Ab sofort in Deutschland erhältlich

Synology DS420+: Ein Blick auf den neuen 4-Bay-Server

Synology bietet mit der DS420+ und der DS720+ zwei neue Diskstation-Modelle in der Plus-Reihe an. Die mit vier Laufwerksschächten ausgestattete DS420+ haben wir uns gleich mal näher angeschaut. Das neue NAS-Gehäuse geht mit einer Preisempfehlung von 518 Euro in den Handel.

Zunächst die relevanten Eckdaten. Die DS420+ ist mit einem Prozessor vom Typ Intel Celeron J4025 mit zwei Kernen ausgestattet und kommt standardmäßig mit 2 GB RAM. An der Geräteunterseite befinden sich zudem zwei Steckplätze, die zur zusätzlichen Beschleunigung der Lese- und Schreibleistung optional mit SSD-Cache vom Typ M.2 NVMe bestückt werden können.

Synology DS420+ Lieferumfang

Standardmäßig werdet ihr zunächst nur die Festplatten-Slots benutzen. Die Performance ist auch ohne SSD für die Verwendung als Netzwerk-Datenspeicher und Mediacenter absolut ausreichend. Entscheiden müsst ihr lediglich, wie die Einschübe bestückt werden. Maximal verträgt die Synology vier Festplatten mit jeweils 16 TB, also eine Gesamtkapazität von 64 TB. Im Praxiseinsatz wird man wohl meist zu kleineren und günstigeren Festplatten greifen.

Bei der Planung der Speicherausstattung unterstützt euch diese Webseite. Ihr müsst nämlich berücksichtigen, dass ihr um eine Ausfallsicherheit zu gewährleisten, nicht die volle eingesetzte Speicherkapazität nutzen könnt. Üblich ist die Verwendung eines RAID-Systems, um jederzeit eine defekte Festplatte ohne Datenverlust ersetzen zu können. Die Festplatten lassen sich mit dem Schnellspannsystem von Synology übrigens ohne zu schrauben fixieren und auch im laufenden Betrieb wechseln.

Wenn die Festplatten eingesetzt sind, schließt ihr das System mit dem mitgelieferten Kabel ans Netzwerk an. Synology liefert zwei Netzwerkkabel mit und stattet die DS420+ mit zwei Ethernet-Ports aus. Wer über entsprechende Infrastruktur verfügt, kann das Gerät also auch mit zwei Anschlüssen ans Netzwerk hängen. Dafür muss der zugehörige Switch allerdings entsprechend konfiguriert sein. Anschließend könnt ihr das System jetzt auf zwei Varianten einrichten: per Webbrowser oder per App. Die DiskStation arbeitet von Haus aus als Server ohne Bildschirm und ihr greift von einem separaten Gerät aus darauf zu.

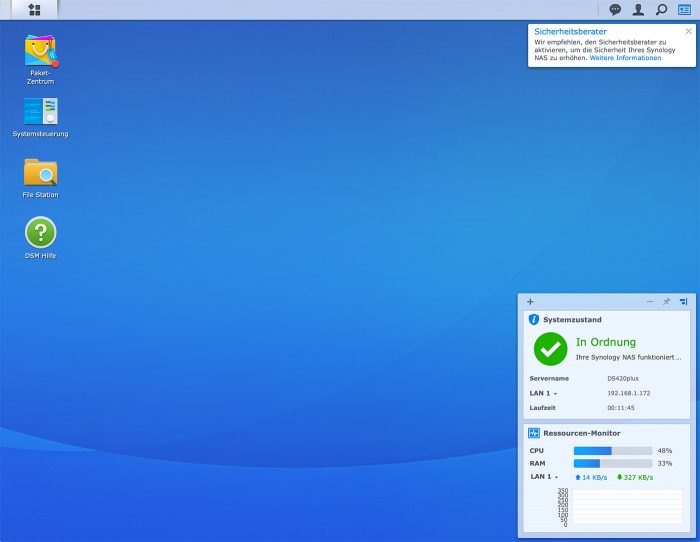

Unabhängig davon, welche Art der Einrichtung ihr wählt, führt euch das von Synology bereitgestellte Betriebssystem Disk Station Manager (DSM) durch die wesentlichen Punkte der Installation. Im Laufe der Einrichtung müsst ihr auch einen Namen für das System vergeben und ein Benutzerkonto inklusive Password erstellen. Hier ist zu beachten, dass mit dem Kontoname das lokale Benutzerkonto des Administrators gemeint ist. Üblich wäre hier, dass der Hauptbenutzer ein Konto unter seinem Namen anlegt, von der Verwendung des Admin-Kontos bzw. den Benutzername „Admin“ raten wir aus Sicherheitsgründen ab.

Jetzt seid ihr „drin“ und und wir empfehlen, euch in Ruhe mit den angebotenen Möglichkeiten zu befassen. Der Disk Station Manager stellt ein breites Angebot an Server-Anwendungen bereit, die sich mit den von Synology angebotenen Apps oder per Webbrowser nutzen lassen. Dazu zählen neben Produktivitäts- und Backup-Lösungen insbesondere auch Multimedia-Apps. So hat Synology eigene Anwendungen für die Verwaltung von Fotos, Musik oder Videos im Angebot. Die DS420+ unterstützt zudem auch den Plex Media Server. Dieser lässt sich ebenfalls über den Paketmanager auf der Station installieren.

Ein besonderes Plus von Synology ist die Kompatibilität mit Apples Time Machine. Der NAS-Server lässt sich mit wenigen Schritten als Ziellaufwerk für Time-Machine-Backups konfigurieren. Diese Funktion findet auch bei uns Anwendung. Vom Time Machine Editor gesteuert, startet Apples Backup-Programm einmal täglich auf dem Mac und schiebt die aktuellen Daten der letzten 24 Stunden auf den Synology-Server.

Die neue Synology DS420+ ist ab sofort in Deutschland erhältlich. Der empfohlene Verkaufspreis des Herstellers liegt bei 518 Euro. Wenn euch vier Laufwerke zu groß erscheinen, könnt ihr auch einen Blick auf die kleineren Systeme des Herstellers werfen, wobei die Plus-Serie die leistungsstärksten Modelle für Privatnutzer und kleine Büros bereithält. Behaltet dabei jedoch immer im Auge, dass ihr sinnvollerweise für Redundanz sorgen, also bei zwei Laufwerken nur mit einem davon kalkulieren könnt. Wer sich alles offen halten will, kann das ebenfalls neue und 458 Euro teure Zwei-Schacht-Modell DS720+ später um ein Zusatzmodul für fünf weitere Laufwerke erweitern. Zum Einstieg in der Plus-Serie gibt es die DS218+ für zwei Laufwerke bereits ab 330 Euro, allerdings ohne jede Erweiterungsmöglichkeit.

Um Unklarheiten zu vermeiden: Die oben genannten Preise beinhalten allesamt keine Festplatten. Ihr bekommt hier lediglich das Gehäuse inklusive Elektronik und Kabeln sowie das regelmäßig aktualisierte Betriebssystem Disk Station Manager.

Leider immer noch kein Ethernet schneller als 1 Gb/s :-((

Reichen dir Ethernetframes die mit 125 mbyte/s übertragen werden, nicht aus…???

So eine Dumme Antwort! Nein 1GBit ist für so eine Maschine zu wenig,die Diskstation kann mehr als 2048 Nutzerkonten verwalten. Selbst mit viel Weniger und Videoüberwachung im Hintergrund ist der LAN-Port der limitierende Faktor!

Was soll die Frage? Wenn ein Anbieter so ne Kiste schon mit SSD-Cache konzipiert und bewirbt, dann sollte man die Perfomance auch aus der Schachtel rausbekommen.

Zudem wenn es sich mit dem Plus-Modell um das Spitzenmodell der Baureihe handelt, ist es im Jahr 2020 schon ein wenig peinlich, nicht zumindest einen 2,5G-Port einzubauen.

8 Bit sind 1 Byte. Dazu noch die Latenz usw…. Schaut euch mal das OSI Modell an…

Ihr seid mir so Informatiker

Mann kann die beiden ja immer noch zu einem Bond zusammenschliessen. Dann hast du 2 Gbit/s.

Was für die meisten Haushalte ausreicht, die eher 2-4 Nutzerkonten haben als die oben genannter 2048. Wer ein anspruchsvolles Business hat, wird wohl auch eher auf ein Rack-gestütztes System als die DS420+ zurückgreifen.

Bündelung von 1Gbit Connections hilft unter SMB leider nicht dem einzelnen Client. Deswegen hilft hier nur mindestens 2,5Gbit+.

Ach du besitzt zwar einen 10Gbps Switch, kannst aber keinen eigenen Fileserver auf die Beine stellen? Hm…

Das im Artikel beschriebene Plus von Synologie mit Apple’s Time Machine BackUp kompatibel zu sein, ist das ein Alleinstellungsmerkmal? Ich recherchiere für eigene Zwecke aktuell zwischen QNAP und Synology. Ich hatte QNAP’s Website und Tests der Geräte so verstanden, dass deren Geräte ebenfalls Apple’s Time Machine unterstützen. Also was ist dahingehend der Unterschied? Über Infos würde ich mich freuen.

Nein ist kein Alleinstellungsmerkmal. Ich wollte die Funktion aber erwähnt haben, da sie meines Erachtens zu den beliebtesten Features für Mac-Besitzer gehört.

Ich möchte Dich aber dann auch darauf hinweisen dass es immer wieder zu Problemen mit dem Backup von Time Machine auf einer Synology kommen kann. Als Folge kannst Du Dein komplettes Backup von Zeit zu Zeit wegschmeißen und neu aufsetzen.

Mir passiert das z.B. regelmäßig, d.h. alle paar Monate. Begriffe für die Suchmaschine neben Synology und Time Machine ist hier der Begriff „Sparsebundle“.

Das Problem hatte ich auch schon mehrmals mit direkt am Mac angeschlossen externen HDs. Ist IMO eher ein generelles TimeMachine Problem als eines von Synology.

Korrekt. Das ist ein allgemeiner Fehler von Time Machine und tritt mit jedem Sicherungsmedium auf.

ich lassen ca. 15 Macs auf einer Synology via Time Machine sichern und hatte in den letzten 4 Jahren nur 2x dieses Problem. Zu beachten ist, das man die Gesamtkapazität der Synol. via Ouota auf die Clients aufteilt:

# tm limited to 200GB

#Time Machine will standard use all the available disk space on an external drive or a external server volume. you can setup a limit how much disk space Time Machine may use. Use the following defaults write Terminal command:

#sudo defaults write /Library/Preferences/com.apple.TimeMachine MaxSize -integer 204800

—-

oder so:

GlobalQuota per destination (TM-Server):

Set up Time Machine for multiple machines with OSX Server-Style Quotas:

nano .com.apple.TimeMachine.quota.plist

GlobalQuota

300000000000

To calculate the interger use MB * 1000000 (300GB in this example).

how many MB bytes you want to allocate to each TM backup

die *quota.plist muß im Syn.-Backup-Volume liegen.

sorry die XML wird nicht dargestellt. Hier ist das auch nochmal beschrieben: https://www.ttl.one/2019/05/create-freenassamba-time-machine-with.html

Das habe ich mittlerweile leider alle paar Wochen.

Ich betreue und verwalte Systeme beider Hersteller. Beiden haben so ihre Vor- und Nachteile. Die (softwaretechnischen) Möglichkeiten sind nahezu identisch in den jeweiligen Klassen.

Synology ist etwas simpler gehalten und vielleicht etwas einfacher zu bedienen für Leute, die sich weniger mit dem Gerät beschäftigen möchten. QNAP bietet dagegen deutlich feinere Settings, die allerdings nicht immer einfach verständlich sind und man manchmal schon nachlesen muss, was gemeint ist. Preis-/Leistung ist bei QNAP (leicht) besser, da du für gleiches Geld etwas bessere Hardware bekommst (Einsteigermodelle ausgenommen).

Die Kaufentscheidung kann dir keiner abnehmen, ist eigentlich nur Geschmacksache. Ich empfehle Einsteigern eher Synology, Leute die ein bisschen „mehr“ machen wollen und auch Lust haben, sich mit dem Gerät zu beschäftigen, empfehle ich eher QNAP. Da es dort auch für kleinere Modelle 5-Bay Erweiterungen gibt und QM2 Karten mit NVme und 10G Ethernet Support. Auch die Container-/Dockerintegration ist bei QNAP deutlich besser gelöst (persönliches Empfinden).

Wie gesagt, mit dem Kauf eines NAS von einem der beiden kann man prinzipiell nichts verkehrt machen.

Natürlich gibt’s noch völlig andere Systeme und Möglichkeiten (Intel NUC, professionellere Systeme,…), aber da gehört auch entsprechendes Know-How zur Verwaltung dazu.

Sorry, aber seit QNAP Werbung auf dem NAS einblendet, ist dieser Laden für mich gestorben.

Ich habe mit QNAPs eher schlechte Erfahrung gemacht. Sie sind im Vergleich zu gleich teuren Synos deutlich langsamer. Firmware Updates dauern ewig, Neustarts fünf mal so lang wie bei einer Syno. Und ich hatte auch schon mehrmals Fehler bei Firmware Updates von QNAPs, die iSCSI-Anbindung ist instabil, etc. Das ist mir noch niemals mit einer Syno passiert.

@asdf: hast du überhaupt ein QNAP-System live gesehen mit der „Werbung“? Das was hier so berichtet wurde stimmt nur zum Teil. Denn es handelte sich dabei nicht wirklich um Werbung. Außerdem betraf es nur einige Modelle und auch die haben ein Update erhalten, wie keine (Eigen-)“werbung“ mehr angezeigt wurde.

@Hotshot: Neustarts dauern tatsächlich (deutlich) länger, da gebe ich dir Recht. Aber wie oft startet man so ein Gerät neu…? Je nach Konfiguration eigentlich nur bei einem manuellen Update, ansonsten merkt der Nutzer das wohl kaum. Leute, die ihr NAS permanent ein/ausschalten habe ich sowieso nie verstanden. Das Gerät ist für den Dauerbetrieb bestimmt.

Aber wie ich ursprünglich schon geschrieben hatte, haben beide so ihre Vor-/Nachteile. Es kommt eben ganz auf den Verwendungszweck an und danach sollte man entscheiden.

Beide Hersteller bieten übrigens Live-Demos ihrer Systeme an, da kann sich ein Ein-/Umsteiger natürlich vorher selbst ein Bild machen.

Schlechte Erfahrungen hatte ich bisher mit keinem von beiden. Mit anderen Consumer-Produkten wie WDMyCloud etc. dagegen schon.

Danke für eure Antworten!

Habe auch noch eine alte DS213j hier rumstehen, aber würde mir heute keine mehr kaufen.

Für 200€ kann man sich ein viel leistungsstärkeres NAS selbst zusammenbauen und das auch mit, wer es braucht, 6 oder sogar 8 Laufwerkslots.

Dann poste bitte mal eine Liste mit den Komponenten

ASRock j4105 mit onboard CPU, dazu beliebiges ITX Gehäuse, als Systemfestplatte vielleicht ne 120gb SSD, kleines älteres PC Netzteil, RAM noch dazu und fertig ist das NAS :)

Ne vielleicht dumme Frage von mir: auch für Time Machine nutzbar?

Ja. Samba installieren und „fruit“ verwenden.

Und welches System läuft dann auf deinem Selbtbau NAS? Das System von Synology ist in meinen Augen gerade der Vorteil einer solchen Lösung, ich möchte es nicht mehr missen.

kann man auch haben …

https://xpenology.org/

@Kidding: Ja gut, dass heißt aber auch, dass du die Software und eventuell auch die Hardware selbst Warten musst.

Und für mich klingt es ein wenig so, als hättest du selbst noch keine eigene NAS zusammengebaut obwohl du es ja stark befürwortest, oder liege ich falsch?

Doch, sorry wenn das nicht so ganz verständlich war.

Was möchtest du denn bei der Hardware großartig warten? Festplatte können bei allen Systemen mal kaputt gehen. Beim Eigenbau NAS hast du wenigstens auch die Möglichkeit Komponenten upzugraden, ohne das ganze System neu kaufen zu müssen.

Bei der Softwarewartung hast du schon recht, vor allem wenn das Ding auch aus dem Internet erreichbar sein soll. Da gibt es aber auch Mittel und Wege, das ganze sicher zu gestalten.

und wo bleibt die 920+?

+1

Wie ist hierbei die Performance des Plex Servers bei 4K Inhalten? Ist der Prozessor dafür schnell genug? Habe hier mit meiner DS415+ unglaublich viele Probleme.

Auch wenn das deine Frage nicht beantwortet, kann sich ggf. ein Blick auf „Infuse“ lohnen wenn das Plex setup probleme macht.

Würde mich auch interessieren. Ich habe deswegen extra eine Nvidia Shield als Plex Server laufen der 4K konvertiert, da mein NAS das nicht schafft.

Infuse auf einen Apple TV spielt wirklich Alles ab, was man auf eine simple Dateifreigabe abspeichert. Speziell die Audi Codecs sind hier wirklich alle mit dabei. So kann man auch 4 4K Streams laufen lassen. Die Rechenpower ist im ATV und nicht in der DS. Darstellung der Filme ist hier auch möglich. Online Untertitel einblenden uvm. Plex und Video Station können da nicht mithalten.

Plex und Infuse sind grundlegend verschiedene Ansätze. Plex ist eine Client/Server Lösung mit entsprechenden Vorteilen sobald mehr als ein Endgerät oder mehr als ein Benutzer darauf zugreift.

Infuse kann aber die Plex Mediathek nutzen, dann hat man das Beste aus beiden Welten…

Das ist richtig. Man kann Infuse als Client für Plex benutzen. Ich war allerdings mit der Stabilität nicht so zufrieden. Da funktionieren die Plex eigenen Apps auf den meisten Plattformen besser. Die Konsolen kann man allerdings vergessen. Da hat Plex noch nie nicht richtig funktioniert.

Ich höre so oft, dass Leute 4K transcodieren wollen, aber was ist da der Sinn? Wenn ich 4K-Material habe, dann will ich es doch auch in 4K schauen, oder!? Andernfalls muss man nicht den Plattenplatz mit den riesigen Files verschwenden.

Auf Emby Server umsteigen und Infuse nutzen.

Ich habe auch die DS415+. Wenn ich die PlexApp vom 4K-TV nutze, habe ich auch Probleme. Nutze ich stattdessen die PlexApp auf dem „Amazon Fire TV mit 4K Ultra HD“, läuft’s einwandfrei. Vorher hatte ich den Arbeitsspeicher massiv erhöht, ohne spürbaren Erfolg. Ich habe mal in irgendeinem Forum gelesen, dass das Abspielgerät die Leistung bringt, nicht der Server, wenn man nicht über die WebApp geht.

Wenn via Direct Play abgespielt wird sollte das gar kein Thema sein. Ich habe zwar kein 4K TV, aber ein Apple TV 4K und spiele oft Blu-ray Content ohne Ruckeln ab. Ich habe allerdings die DS418PLAY, nicht die Plus-Serie. Hast Du auch auf dem Client auf den neuen Player eingestellt (inzwischen Standard). Der alte Player konnte etliche Formate nicht gut abspielen.

Daß der Switch die Anbindung mit zwei LAN-Kabeln unterstützen muß, stimmt so nicht. Es gibt nämlich unterschiedliche Methoden, wie man das konfigurieren kann. Synology gibt hier an: „Adaptive Load Balancing“ und „Aktive/Standby“, die nicht im Switch konfiguriert werden müssen. Lediglich die statische und dynamische Link Aggregation (LACP) erfordert die Konfiguration im Switch.

Die Frage bei einer mehrfachen Anbindung ans LAN ist natürlich, was will man erreichen? Nur Ausfallsicherheit? Dann würde „Aktiv/Standby“ genügen. Oder möchte man mehr Durchsat wie bei LACP?

Wobei der Durchsatz ja nur zum Tragen kommt bei parallelen laufenden Zugriffen. Eine einzelne Datei wird nicht schneller übertragen, was viele nicht verstehen.

ja, LACP mit 2GBit bringt nur etwas, wenn man von mehreren Clients aus zugreift. Aber z.B. einmal per Smartphone auf der PhotoStation gearbeitet und der 2. Client hat die vollen 1 GBit zur Verfügung. Oder 1 x läuft ne Aufnahme vom Receiver per SMB zur DiskStation und einmal volle 1 GBit für Daten-Schaufelei vom PC / Mac aus. Vorher mußte alles über eine 1 GBit-Leitung gehen, jetzt kann es aufgeteilt werden. Ist wie Multi-Core im PC. Heißt auch nicht unbedingt, daß ein 8-Core-System 8 x schneller ist als ein Single-Core-System.

Trotzdem denke ich, 2 x 1 GBit ist besser als 1 x 1 GBit.

seit ich zu Catalina upgedatet habe habe ich massive Probleme mit Time Machine backups auf meiner Synology… Das erste Backup funktioniert, danach kommen nur noch Fehlermeldungen… kann mir das jemand bestätigen?

Ich lasse wie gesagt nur 1x täglich sichern, das funktioniert. Womit Catalina aber definitiv ein Problem hat, ist das dauerhafte Mounten von Volumes. Seit 10.15.5 muss ich wieder regelmäßig den Finder gewaltsam beenden, davor war es relativ lange stabil.

Nach dem Update konnte mal wieder das TM Backup nicht geladen werden, mit dem Verweis es muss ein neues erstellt werden…, habe dann auf das erste neue Catalina Update gewartet mit dem gleichen Ergebnis….

Dann wollte ich ein neues anlegen geht nicht mehr, Meldung Dateien können nicht kopiert werden.

Das löschen des Verzeichnisses auf der DS und neu anlegen hat auch nichts gebracht.

Habe aufgegeben und mache meine Backups wieder manuell auf zwei SSD.

Das mit nicht lesen könnenden hatte ich regelmäßig schon seit Generationen deshalb habe ich die zwei SSD als Bavkup und die große Datenmenge wo Verluste ärgerlich aber nicht lebensnotwendig sind, habe ich auf der DS.

Ich verwende btrf auf den Platten auf meinem Synology-NAS und erstelle mit dem Snapshot Replication tägliche Snapshots für meinen Timemachine Backup-Folder. Wenn alle paar Wochen oder Monate MacOS das Backup zerstört und ein neues Backup erstellen möchte, spiele ich den Snapshot vom Tag zuvor ein und alles geht wieder. Damit habe ich endlich keine Gefahr mehr meine Backup-Historie zu verlieren. Eine Anleitung wäre evtl. mal was für einen Artikel hier.

Prima Idee. Allerdings traue ich Time Machine über Netzwerk einfach nicht. Aus dem Grund sichere ich wieder auf eine lokale Festplatte.

Gibt es denn auch Möglichkeiten ein iOS-System vollautomatisch lokal zu sichern? Also eine TimeMaschine fürs iPad? Ich brauche mein MacBook nur noch als Backup-Medium und zum Drucken. Wenn man das reduzieren könnte, wäre es nicht schlecht.

Nein, das iOS / iPadOS Backuo geht nur auf den Rechner.

vielleicht mit iMazing auf dem Mac das dann die Daten auf die Synology schreibt.

Geht direkt auf das NAS, seit über 1 Jahr problemlos, iMazing und DS916+.

Gestern die ds1019+ bestellt… meiner Meinung nach immer noch das p/l Mittel der Wahl derzeit, wenn man 4k Transcode und Skalierbarkeit haben möchte.

Es mag sein, dass das p/l bei den günstigeren Geräten bei Synology noch ganz ok ist, aber im Bereich einer DS mit plus, 5, 7, 9 oder 10 davor, also alles was eher im small business Bereich oder höher angesiedelt ist, sind die Dinger einfach zu teuer. Hier bietet sich dann doch eher der Aufbau eines vernünftigen NAS mit Server-Komponenten von z.B. Supermicro (Buildblocks) an. Und darauf läuft dann am besten ZFS (z.B. mit FreeNAS auf ESXi), wenn einem die Daten etwas wert sind.

Ich hatte vor Jahren eine Synology und habe mich wieder verabschiedet davon. Ansich ist das schon ein gutes System und auch leicht zu handhaben. Größtes Manko ist meiner Meinung nach aber die Tatsache das du die Festplatten die in der Synology dann verbaut sind, auch nur wieder mit einer Synology ausgelesen werden können. Das war für mich der Grund mich wieder davon zu trennen. Ist übrigens meines Wissens bei Qnap genauso.

Habe aktuell einen MacMini als Server in Betrieb an dem eine externe Festplatte von WD per USB dranhängt. Sollte mal mit dem Server was sein, ziehe ich die Platte einfach ab und stecke sie direkt am iMac ein und kann auf meine Daten zugreifen.

Ich habe vor ein paar Jahren die beiden mit ext4 formatierten Platten eines Raid 1 aus einem kaputten Synology NAS in einem selbstgebauten „Server“ per SATA angeschlossen. Open Suse hat automatisch das Raid 1 erkannt und ich verwende es so immer noch.

Mit RAID 1 geht das. Mit allen anderen Typen nicht. Es ist nicht mal möglich die Platten zwischen jeder Art von Syno zu tauschen ohne neu Formatieren zu müssen.

Da hab ich dann wohl Glück gehabt:-) Danke für die Info!

ich kopiere die wichtigen Daten von der Synology regelmäßig mit einem einfachen Backupprogramm auf Festplatten die an einem Mac angeschlossen werden. Die Platten werden dann im Austausch Offsite gelagert.

Wenn man einen „echten“ Server mit einem „richtigen“ Raid-Controller hat, dann klappt es auch nicht, Platten von System A in System B zu stecken und man kann das Raid wieder verwenden.

Prinzipiell sollte man den Zugriff auf die System-Platten nur als letzten Rettungsanker nutzen. Ein Backup auf externe Medien läßt sich immer und überall auslesen. Man kann z. B. auch ein manuelles Backup erstellen und so mit Platten am Desktop synchronisieren. Ich erstelle z. B. ein Backup via Datensicherung (DSM 4.x), ein Backup via Time-Backup und dann synchronisiere ich noch auf USB-Platten am iMac via dirsyncpro vom Mac und von der DiskStation aus.

Wichtig ist, ein Backup immer auf unterschiedliche Dateisysteme zu erstellen. Z. B. auf ext-Dateisysteme für Linux, auf HFS+ und / oder APFS für Mac, auf FAT32 / NTFS für Windows.

Theoretisch könnte man auch ein Raid 5 der Synology DiskStation an einem anderen Linux nachbauen. Man muß nur wissen, welche Platten wie verdrahtet sind. Ein SHR, wie es oft von Synology empfohlen wird, klappt dann natürlich nicht, weil dort die Raid-Level gemischt werden.

Man muß auch nicht immer 100 % der Daten sichern. Man kann die Shares auch unterschiedlich sichern und verteilen. Meine Daten haben z. B. auch eine unterschiedliche Wichtigkeit. Es gibt Daten, auf die kann ich verzichten, dann gibt es Daten, die ich ungern verlieren würde. Und dann gibt es das Heiligste was ich unter keinen Umständen verlieren möchte. Nach dieser Wichtigkeit erstelle ich auch meine Backups. Um das „Heiligste“ kümmere ich mich immer persönlich, da kommt kein Automatismus in Frage, der im Fall der Fälle nicht klappt.

Öhmmmm, nur 1 x USB Hinten ???

Das ist nicht gut..hab bei meiner 415+ mein Backuplaufwerk und die USV dran hängen.

Könnte natürlich auch mein Backuplaufwerk per eSATA anschließen…aber der ist bei der DS scheinbar auch weggelassen wurden. PS. ohne den eSATA, wie schleißt man dann denn die Erweiterungseinheiten an?

Ich bin eigentlich nur mehr bei Synology weil ich keinen Bock habe, den Reverse Proxy in einem Qnap über Apache & Co einzurichten.

Kennt da jemand Lösung für? Qnap -> simple Reverseproxy App?

Dann würde ich sofort wechseln …

Danke

Schöner Beitrag. Man könnte erwähnen, dass die 420+ ohne direkten Vorgänger ist und wohl die 418play ablöst.

Die Festplatten auf dem Foto mit der 3TB WDred sollte man allerdings nicht verwenden. WD hat die WDred (ohne „Pro“) stillschweigend von der CMR-Methode auf SMR-Schreibtechnik umgestellt.

Diese Festplatten machen bei Verwendung in einem RAID massiv Probleme. Bei SMR muß bei jeder Änderung immer ein kompletter 256MB-Block neu geschrieben werden. Dadurch kommt das RAID aus dem Tritt, die Festplatte wird als „fehlerhaft“ erkannt und aus dem Verbund geworfen.

Erkennbar ist es bei diesen Plattengrößen bis 6TB an der Endung EFAX für die Teilenummer. Größere Platten der WDred-Serie haben diese Bezeichnung auch, ab 8TB aber wohl noch in CMR-Technik.

Alternativen sind die WDs als Pro, Seagate Iron Wolf oder die entsprechenden Toshibas.

Danke für die Info, bin nämlich kurz vor dem Kauf einer 918+ und wollte die normalen Red (ohne Pro) nehmen, dachte mir schon, dass der Preis der Platten im Vergleich doch einen Haken hat. Überlege, ob es Sinn macht bis zur 920+ zu warten – wahrscheinlich vor allem, weil die 918+ dann günstiger wird?

Ich glaube auf dem Foto ist EFRX zu lesen. Die sollten sicher sein für den Betrieb im NAS.