Einfache Nutzung wird möglich

Stable Diffusion 2.0: KI-Bildgenerator macht großen Sprung

Seit mehreren Monaten verfolgen wir die Entwicklungen rund um den KI-Bildgenerator Stable Diffusion mit großen Interesse. Nicht nur, weil uns die grafisch beeindruckenden Ergebnisse faszinieren, die nach Eingabe kurzer Textbeschreibungen quasi aus dem Nichts erstehen, sondern auch, weil mittlerweile endlich die ersten einfachen Implementierungen für jedermann bereitstehen.

Stable Diffusion 2.0: Generiert Bilder aus dem Nichts

Einfache Nutzung wird möglich

Mit Mac-Anwendungen wie Diffusion Bee oder CHARL-E und iPhone-Applikationen wie dem jüngst auf ifun.de vorgestellten Freeware-Download Draw Things braucht es inzwischen weder einen Informatik-Abschluss um eigene Experimente mit Stable Diffusion anzustellen, noch muss das Grundvertrauen in eine der zahlreichen Online-Plattformen aufgebracht werden, die die Nutzung von Stable Diffusion im Netz ermöglichen.

- Stable Diffusion für den Mac: Bildgeneration CHARL-E

- Stable Diffusion für den Mac: Bildgeneration Diffusion Bee

- Stable Diffusion auf dem iPhone: App-Tipp Draw Things

Mit den Downloads für macOS und iOS lässt sich die Bild-Erstellung durch intelligente Algorithmen lokal auf den eigenen Maschinen ausprobieren. Account- und kostenfrei, ohne irgendwelche Datenspuren zu hinterlassen. Und es kann nur besser werden.

Stable Diffusion 2.0: Grafik-Ergebnisse sollen hochwertiger sein

Stable Diffusion 2.0

So wurde heute Version 2.0 des Stable-Diffusion-Modells auf der Code-Plattform GitHub veröffentlicht. Die neue Version bietet viele große Verbesserungen an. So stehen neue Text-to-Image-Modelle bereit, die Bilder mit deutlichen Qualitätsverbesserungen in Auflösungen von 512 px x 512 px und 768 px x 768 px generieren können.

Super-Resolution-Upscaler wertet Auflösungen auf

Ein neuer Super-Resolution-Upscaler kann kleine Bilder zudem auf Auflösungen von bis zu 2048 px x 2048 px hochskalieren. Das ebenfalls neue Depth-to-Image-Modell erweitert die sogenannte Image-to-Image-Funktion dahingehend, dass Bildeingaben mit Text- und Tiefen-Informationen kombiniert werden können.

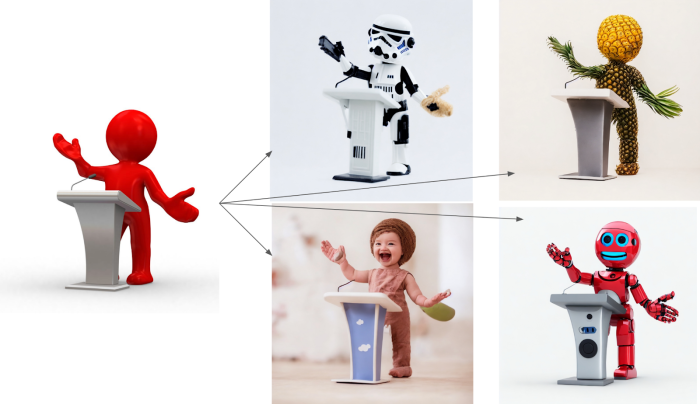

Stable Diffusion 2.0: Das Depth-to-Image-Modell

Damit lassen sich Bilder inhaltlich komplett umgestalten, behalten aber die vorhandenen Tiefen-Informationen und entsprechend auch ihre Komposition. Das Auswechseln von Bildbestandteilen soll durch das neue Inpainting-Modul zudem deutlich verbessert worden sein.

Depth-to-Image-Modell in Aktion

Wir melden uns erneut, sobald Stable Diffusion 2.0 wieder in einfach bedienbaren Mac- und iPhone-Apps angeboten wird.

Geil

Richtig gut, vielen Dank euch!:)

Sehr gut.

Die App ist richtig cool, zieht aber auch ordentlich am Akku :0

Jaaa, mein 16″ M1 Max/64GB ist ohne Strom nach ca 2 Stunden komplett leer…sonst hält das Teil ewig, selbst beim schneiden von 4K Projekten in Davinci kann man Stunden damit arbeiten.

Danke, dass ihr regelmäßig Neues aus der AI-Community berichtet :)

Vor allem seit 2017 ist einiges passiert, was in den Mainstream-Medien nur stiefmütterlich Erwähnung findet.

Naja es interessiert den Mainstream halt auch nicht.

Schade, funktioniert lokal auf dem 13″ MBP M1 leider nicht zufriedenstellend – die Bildberechnung dauert viel zu lange und es kommt nix dabei raus…

Das nix rauskommt dürfte allerdings am verbesserungwürdigen Text-Input liegen.

Dassss mit 2 s

Egal was ich eingebe, es kommt nur Murks raus :) ich habe den Dreh einfach nicht raus mit den Text Eingaben. Was gebt ihr so ein um Bilder mit Landschaften oder im Cyberpunk Style rauszubekommen?

…check mal lexica.art :)

DAS ist mal ein sehr geiler Tipp! Dankeschön :)

Total faszinierend, aber auch etwas gruselig. Kann mir jemand erklären wie sowas funktioniert???

Ich find’s gruselig!