Sichtkontrollen durch Apple-Mitarbeiter

Kinderporno-Scan: Apple hofft auf ein Missverständnis

Überraschend hat Apple am Donnerstag über eine neue Initiative zum Schutz von Kindern informiert, die Fotos von mehreren hundert Millionen iPhone-Nutzern bereits auf deren Geräten scannen und lokal auf verdächtige Inhalte hin prüfen soll, noch bevor diese ihren Weg in Apples iCloud-Speicher antreten.

Apples Veröffentlichungen zum Thema, die der Konzern auf dieser Sonderseite zum Download anbietet, sorgten jedoch nicht nur für Zuspruch, sondern ließen auch viele kritische Stimmen aus Wissenschaft, IT-Sicherheit und der Krypto-Community laut werden. ifun.de berichtete:

- Kinderporno-Scan auf allen iPhones: Apple erntet Kritik von allen Seiten

Grundsätzliche und spezifische Kritik

Neben der grundsätzlichen Kritik daran, dass Apple dem iPhone so eine Hintertür verpasst, die von totalitären Regime auch zum Auffinden ganz andere Inhalte genutzt werden könnte, sind viele Kritiker auch mit Apples konkreter Implementierung nicht einverstanden.

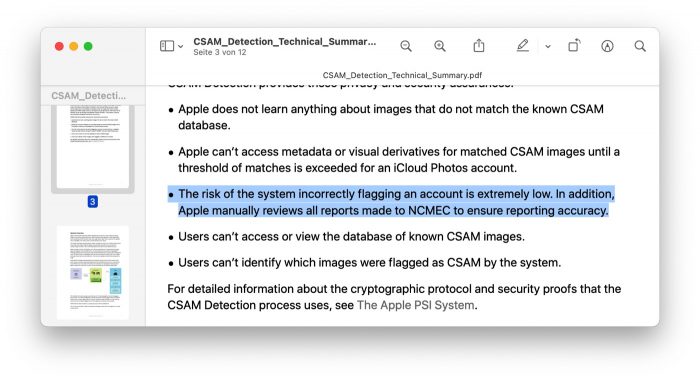

Bei der Suche nach illegalem Bildmaterial prüft Apples System nämlich nicht nur auf spezifische Fotos mit eindeutigen Fingerabdrücken sondern besitzt ein gewisses Maß an Spiel (Stichwort: perceptual hashes), um auch leicht modifizierte Bilder zu erkennen. Ein Verfahren, das anfällig für Falsch-Positiv-Meldungen ist.

Perceptual Hashes: Andere Inhalte, ähnliche Hash-Werte

Sichtkontrollen durch Apple-Mitarbeiter

Ausgerechnet hier argumentiert Apple dann mit Sichtprüfungen: Sollte die neue Fotoerkennung bei einem Anwender anschlagen, würden Apple-Mitarbeiter die fragliche Bild-Dateien persönlich in Augenschein nehmen, ehe die zuständigen Behörden kontaktiert werden.

Die Befürchtung: Im Zweifelsfall könnten Apple-Mitarbeiter fortan explizite Darstellungen eurer Partner oder ganz private Selfies sichten, wenn diese von den eingesetzten Algorithmen fälschlicherweise als vermeintlich problematische Bildinhalte markiert wurden.

Auf Foto-Treffer folgt eine Sichtkontrolle durch Apple-Mitarbeiter

Apple hofft auf Missverständnis

Ausnahme-Beispiele, von denen sich Cupertino nicht beeindrucken lässt. So hat der Konzern im Nachgang an den seit gestern tobenden Sturm der Entrüstung ein internes Mitarbeiter-Memo verfasst, in dem der Belegschaft versichert wird, dass die neuen Funktionen nur besser erklärt werden müssten, um den Missverständnissen zu begegnen denen die Kritiker unterliegen.

Apple will berechtigte Länder auswählen

Zudem hat Apple gegenüber mehreren US-Medienvertretern verlauten lassen, dass die Funktion vorerst ausschließlich in den Vereinigten Staaten bereitgestellt wird und weiteren Ländern erst nach vorhergehender rechtlicher Prüfung durch Apple offeriert werden soll.

Das Mitarbeiter-Memo des Apple-Managers Sebastien Marineau-Mes, dem eine zusätzliche Grußnote des „National Center for Missing & Exploited Children“ (NCMEC) beilag, haben wir im Anschluss eingebettet.

Heute wird der erweiterte Schutz für Kinder offiziell vorgestellt, und ich möchte mich bei jedem Einzelnen von Ihnen für Ihre harte Arbeit in den letzten Jahren bedanken. Ohne Ihren unermüdlichen Einsatz und Ihr Durchhaltevermögen hätten wir diesen Meilenstein nicht erreichen können.

Die Sicherheit der Kinder ist eine so wichtige Aufgabe. Wie es sich für Apple gehört, war zur Erreichung dieses Ziels ein starkes funktionsübergreifendes Engagement erforderlich, das die Bereiche Technik, allgemeine Verwaltung, Personalwesen, Recht, Produktmarketing und PR umfasst. Was wir heute ankündigen, ist das Ergebnis dieser unglaublichen Zusammenarbeit, die Werkzeuge zum Schutz von Kindern bereitstellt und gleichzeitig Apples Engagement für die Privatsphäre der Nutzer aufrechterhält.

Wir haben heute viele positive Reaktionen erhalten. Wir wissen, dass einige Leute Missverständnisse haben und nicht wenige sind besorgt über die Auswirkungen, aber wir werden weiterhin die Funktionen erklären und detailliert beschreiben, damit die Leute verstehen, was wir aufgebaut haben. Und während noch viel harte Arbeit vor uns liegt, um die Funktionen in den nächsten Monaten bereitzustellen, wollte ich diese Mitteilung weitergeben, die wir heute vom NCMEC erhalten haben. Ich fand sie unglaublich motivierend und hoffe, dass Sie das auch tun.

Ich bin stolz darauf, bei Apple mit einem so tollen Team zu arbeiten. Ich danke Ihnen!

Wegen <1% muss die Masse überwacht werden?? Wie war das damals noch mit FBI und Terrorismus? Heuchler

Nein, später kommen noch die Terroristen dazu. Dann die Drogendealer, dann schwarze, dann schwule, dann das Finanzamt, dann dein Chef und zu guter Letzt deine Ehefrau. Ist doch toll. Applaus Applaus.

Privacy in my Ass. Ich habe keine Lust darauf das Apple-Mitarbeiter sich „im Zweifelsfall“ die Nacktbilder meiner Partnerin angucken. Was für ein verlogener Verein.

Die gucken an Ihr garantiert auch nichts kaputt…

@Onkel was für ein dämlicher Kommentar vom dir!

hier geht es ums Prinzip. Es ist mein Handy, die Bilder sind privat! Da hat kein Apple Mitarbeiter drauf zu schauen!

95% der Kommentare zu diesem Artikel sind dämlich. Da reihen wir beide uns ganz gut ein.

Wir wollen eine friedliche Welt mit kranken Menschen ohne aber jemanden der dies kontrolliert.

Wie hat sie Merkel schon mal gesagt: ich hoffe auf den gesunden Menschenverstand meiner Mitbürgerinnen und Bürger.

Du befürwortest dieses Vorhaben Apples also?

Klar, KaroX und theft sind die Ur-Fanboys in der Community hier. Die würden sogar Hexenverbrennung akzeptieren solange Apple es fordert. Und wir haben uns immer gefragt wie es möglich war früher Menschen nur weil sie schwarz waren zu versklaven. Alle schwarzen unter Generalverdacht bitte, denn sie verkaufen nur Drogen oder verbreiten Aids.

Hä?

Danke für deinen konstruktiven Kommentar. Ich habe sie so verstanden, als befürwortete sie Apples Vorhaben. Und da ich sichergehen wollte, ob ich das richtig verstanden habe, habe ich nachgefragt. Sollte man immer machen, bevor man von etwas Falschem ausgeht, findest du nicht?

Wir haben jemand der das kontrolliert und dafür zuständig ist. Und zwar unsere Rechtsorgane!

Das ist keine Aufgabe von Apple! Apple hat hierzu keinen Auftrag der deutschen Regierung!

Mit so einem ersten Schritt fängt es an und dann geht es schleichend immer weiter, bis wir dann in 20 Jahren alles überwacht haben!

Apple lass die Finger davon!

Deswegen gibt es das ja auch nur in USA… seid ihr alle etwas blind beim lesen? Frag mich eh wieso ifun überhaupt darüber berichtet, interessiert uns deutsche halt 0

Stimmt, die Sicherheit der Kinder ist wichtig, außer sie müssen iPhones zusammenbauen, Edelmetalle schürfen oder Elektroschrott auf großen Mülldeponien recyclen. Als würden Apple die Kinder so wichtig sein, außer der Profit stimmt natürlich, unabhängig dacon ob man Steuern korrekt zahlt oder nicht.

+1

+1

+1

Nur gut das es nur Apple betrifft, oder ? Primark, Esprit, SOliver, Google und Co sind ja die Guten. Ein wenig einseitig deine Meinung und nein, macht es nicht besser, das andere das auch machen.

Hier geht es aber um Apple.

Und weil es andere manchen ist das okay? Hast echt Köpfchen bewiesen.

Das nennt man whataboutism und ist unglaublich kleingeistig.

nicht alle schreiben dich auf die Fahne, die guten Helden zu sein – ist schon ein gutes Stück dreister

Auch dagegen unternimmt Apple etwas. Ein riesiges Unternehmen wie Apple kann aber nicht jede Tätigkeit seiner Zulieferer 24/7 überwachen lassen.

Davon mal abgesehen, was möchtest du mit dem Kommentar sagen? Wenn Apple die Kinder in Wahrheit egal sind, müssen sie ja etwas anderes damit bezwcken. Was?

+ 1

Apple überwacht die Zulieferer auf Kinderarbeit und positioniert sich klar gegen Kinderarbeit…

Findet man alles im Internet.

Ja, im Internet steht auch dass es Corona nicht gibt und dass Belarus ein sicheres Land ist. Und früher wurde gerne mal behautet die Erde sei eine flache Scheibe.

Hast Du eigentlich eine Ahnung, wie die seltenen Erden gewonnen werden?

Und „Apple kann nicht überall sein“ ist ganz schön einfach machen. „Wollte das nicht, konnte aber nicht überall sein! Steht ja auch im Internet!“

+1

+1

+++++1

Wird ja immer doller…

Jetzt rückt z.B. ein harmloses Badewannenbild der Kids, das zwischen zwei Familien ausgetauscht wird, ins Verdachtsfadenkreuz…

Ein Hoch auf das neue Denunziantentum…

Wenn es vom Kinderiphone verschickt wird und die Eltern es in der Kindersicherung aktiviert haben. Es wird auch sonst niemand benachrichtigt.

Du irrst Dich. Es geht hier um etwas Anderes. Siehe Artikeltext.

Ute. Nein der Original-Kommentar verwechselt was. Solange deine Bilder nicht in der CP-Datenbank sind, werden sie auch nicht geflaggt. Das iPhone sucht nicht einfach nach Bildern von nackten Kindern.

Und genau wegen solcher Missverständnisse schreibt Apple, dass Kommunikation wichtig ist.

aber gescannt und abgeglichen und ggf. händisch begutachtet und was ist, wenn der Algorithmus etwas meldet weil halt… gruseliges 1984

Hallo Melvin. Ein Kritikpunkt an dem geplanten Vorgehen Apples ist, dass Hashes nicht eindeutig sein könnten. Dadurch würde es dann ggf. zu Fehlerkennungen kommen und Apple würde annehmen, dass entsprechende Bilder auf deinem Gerät sind und die Behörden informieren – obwohl dem gar nicht so ist. Und mit den entsprechenden Folgen für dich.

Genau das beschreibt der Artikel.

Das Erkennen dieser Bilder, respektive das Zuordnen eines Bildes zu einem bekannten CP-Bild ist aber schon an sich ein Problem.

Ich kann mir nicht vorstellen, dass der Algorithmus immer sicher erkennt, ob ein Bild medizinischer Herkunft ist oder Missbrauch darstellt.

Einfaches Beispiel, meine Freundin (Japanerin aus der Präfektur Wakayama) ist Pädiaterin, ich bin deutscher Mediziner (aus Erftstadt, ja das was abgesoffen ist).

Oftmals helfe ich meiner Freundin bei Publikationen und Material für ihre Vorlesungen (Übersetzung, PowerPoints, Struktur der Publikation, Abstract erstellen, etc.). Letztens ging es um das Thema „adrenogenitales Syndrom“. Dabei wird bei weiblichen Säuglingen lediglich eine einfache Untersuchung durchgeführt, diese beschränkt sich auf ein Spreizen der großen Labien, um den Scheideneingang sichtbar zu machen. Ist die Klitoris physiologisch vergrößert, muss, bei massiver Größenzunahme der Verdacht auf ein adrenogenitales Syndrom ausgesprochen werden. Für Anfänger nicht leicht zu erkennen. Deshalb war ihre Lektion mit Bildbeispielen versehen, die ich aus deutscher Fachliteratur entsprechend ergänzt habe.

Wir nutzen dafür schonmal ganz gerne iCloud. Die e-Mails versenden wir über Naver (koreanischer Anbieter). Bin gespannt wann die ersten Bilder bei Apple Alarm auslösen. Kann mir gut vorstellen, dass vor allem us-amerikanische Kollegen jetzt zweimal überlegen, auf welcher Ebene sie Wissen teilen und über welche Endgeräte welches Anbieters.

Deine medizinischen Bilder werden wohl kaum im Index von Gewalt gegen Kinder sein und werden somit nicht als solches erkannt. Bitte genauer informieren

Der Index beinhaltet bekannte Missbrauchsbilder. Nahaufnahmen von Genitalien oder sogar teils bekleidete Kinder und Jugendlich werden u.a. in Deutschland schon strafrechtlich sanktioniert.

Es reicht doch schon die Angst vor falschen Verdächtigungen aus. Apple wird Bilder melden, nicht den Kontext.

@Melvin: Der Original-Kommentar verwechselt gar nichts, Melvin. Um abzugleichen, ob Photos -oder xyz- in einer xyz-Datenbank sind, müssen diese zwingend (daraufhin) analysiert werden.

Was willst Du uns -ggfs. im Verbund mit Apple- vorliegend dann (noch) kommunizieren? Na??

Ich sage es mal als Vater von zwei Kinder und ohne das ich hier persönlich jemanden angreifen will. Es gibt so Fotos, die gibt man einfach nicht weiter. Und da gehören auch Fotos von nackten Kinder dazu. Seien es die eigenen oder von anderen. Und da ist es egal ob die in der Badewanne sitzen oder nackt am Strand. Habt ihr die Kinder um Zustimmung gefragt, dass die Fotos weitergereicht oder auf der Homepage veröffentlicht werden? So unschuldig das für Eltern auf den ersten Blick auch alles ist. Das Internet vergisst nie etwas. Und gute Freunde können solche Fotos auch ungefragt ihren Freunden weiterreichen usw. und irgenwann landet es da wo es nicht hingehört.

Ich habe kein einziges Bild auf dem meine Kinder nackt abgebildet wurden. Sei es als Säugling, Kleinkind oder Schulkind. Wofür auch?

Es sind aber nicht alle so von Angst und Prüderie durchdrungen wie du. Nacktheit ist etwas vollkomen natürliches! Es ist generell nicht schlimm! Es ist vollkommen normal und verbessert sogar nachweislich das Körpergefühl eiones Kindes. Was ist nur los mit dieser Gesellschaft? Wenn jemand mit einem Brot umgebracht wird, dann dürfen keine Bilder mehr von Brot in Umlauf gebracht werden, weil das Gewalt auslöst oder was?

Alles muss unterdrückt und versteckt werden, hauptsache man muss nicht darüber reden und mit gesundem Menschenverstand in persönlichen Gesprächen, ganz ohne Handy, ordentlich aufklären. Wo kämen wir da auch hin… ist doch viel einfacher die Filterdatenbank zu erweitern, in diesem Fall durch Brot.

Stichwort: „Prüderie und Angst“

Ich hoffe, auch der Fairness halber, dass deine Kinder ebenfalls die Nackbilder von Dir und deiner Frau an ihre Freunde weiterreichen dürfen.

Aber davon ab. Es sind deine Kinder. Wenn es für Euch normal ist die Bilder eurer nackten Kinder rumzuzeigen, dann soll es so sein. Ich brauche keine Fotos von meinen Kinder auf denen sie nackt abgebildet sind. Sicherlich ist Nacktheit was vollkommen natürliches. Aber brauche ich davon Fotos? Für was?

Ich habe keine Fotos und laufe damit auch nicht Gefahr, dass diese durch eine Unachtsamkeit dritter als Wichsvorlage für andere dienen könnten. Und ja, davor habe ich wirklich Angst. Denn diese Fotos sind nur schwer aus dem WWW zu entfernen.

Es reicht ja, dass dein Familienfoto aus dem Urlaub, ganz ohne Nacktheit, einen ähnlichen Hash besitzt wie eines der Fotos aus der Vergleichs-DB. Hierzu muss es nichtmal ähnlich aussehen, Bilddetails sind da egal. Das wird dann ein Apple-Mitarbeiter checken. Passieren wird weiter nichts, aber dein privates Foto hat ein Dritter gesehen und das allein geht schon einmal gar nicht und wäre für mich Grund genug der iCloud den Rücken zuzukehren.

Danke!

Es geht ja nicht nur um die Weitergabe sondern auch darum das die Fotos die du mit deiner Frau teilst ebenso gescannt werden. Nämlich alles was in der icloud liegt. Das können auch Bilder sein die einen Babypopo zeigen oder ähnliches. Ich bin der Meinung das Apple lieber mal mit Amazon und Google deren Servern habe solche Bilder nix verloren.

Beste Vater. Ich mache das selbe.

wir machen das genauso.

Du willst das so.

Wenn dieses Badewannenbild dergestalt ist, daß es in die Datenbanken der NCMEC und anderer Organisationen aufgenommen wurde, dann kommt es mit Recht ins Fadenkreuz, denn nur dann tritt Apples „Scan“ in Kraft.

Apple baut also eine Hintertür in seine Verschlüsselung. Mal sehen wer die dann alles irgendwann missbraucht.

Mich wundert warum der Aufschrei erst jetzt kommt? – Das war vor eineinhalb Jahren schon bekannt: https://www.iphone-ticker.de/kindesmissbrauch-apple-scannt-icloud-fotos-auf-bekannte-bilder-151938/ – oder ist hier etwas grundsätzlich anders als in dem Artikel?

Weil es damals die iCloud Foto Mediathek nur betroffen hat und nun aber die iPhone Foto Mediathek. Wer das also nicht wollte konnte einfach die iCloud Foto Mediathek abschalten und fertig. Nun wird aber etwas auf den Geräten selbst gemacht.

Laut Apple ist diese Funktion aber nur dann aktiv wenn die Fotos in die Cloud hochgeladen werden.

List du wo genau?

Das passiert wenn überhaupt „vor“ Verschlüsselung.

Apple hat schon immer sozusagen den General Schlüssel für die iCloud Daten. Das ist genau der Grund, weshalb ich iCloud nicht nutze. Und es war schon vor langer Zeit seitens Apple versprochen worden, dass dies geändert würde, Stichwort Ende zu Ende… Wird wohl aber nie kommen offenbar.

Das liegt teils in der Natur der Sache (andere Daten sind end-zu-end verschlüsselt und dagegen gar nicht einsehbar). Allerdings ist das kein Problem eines Anbieters, sondern generelle Praxis. Dann muss man eben ein Leben außerhalb jeglicher digitaler Inhalte und Geräte führen.

Hallo Phil. Das ist schwarz/weiß gedacht. Es gibt hier eben nicht nur ein entweder oder (also entweder digitale Dienste/Cloud Dienste nicht nutzen oder sich mit bestimmten Dingen abfinden, wie zum Beispiel der quasi nicht vorhandenen Verschlüsselung der iCloud Fotos).

Ich nutze für die Sicherung meiner Fotos einen anderen Anbieter, der Ende zu Ende verschlüsselt, somit darf ich also trotzdem „digital teilhaben“, ohne dass der Anbieter Einsicht in meine Daten hat.

Jeder Anbieter scannt die Fotos, dann eben in der Cloud. Das ist seit langer Zeit üblich.

Phil: Nicht jeder Anbieter tut dies von sich aus.

Bei aktiver Ende-zu-Ende-Verschlüsselung ist dies technisch auch gar nicht möglich.

Dürfen wir den anderen Anbieter erfahren?

iMassage: Ich nutze seit vielen Jahren Tresorit.

Das Missverständnis bei Apple ist, dass sie denken, die Anwender hätten da was missverstanden.

Danke, perfekt ausgedrückt!

Genialer Kommentar !!!

+1

Das geht wirklich überhaupt nicht!

Wenn ich also zB ein „Nacktfoto“ meines in unserem Planschbecken spielenden Kindes auf dem iPhone habe, und dieser komische Algorithmus zufällig eine Ähnlichkeit mit einem irgendwie existierenden Kipo-Bild entdeckt, dann schaut sich also ein Apple Mitarbeiter mein nochmal genauer Kind an??

Ich glaube es hackt Apple!!

Und wenn das ein Ami ist geht der Alarm gleich an so Prüde wie die sind.

Natürlich könnte man auch erstmal alle Deine Bilder anschauen um zu checken ob das ne Ausnahme war ;)

Es ist ein Unterschied zwischen einem Nackfoto im Pool deines Kindes und Fotos von Kindern, die missbraucht werden.

Der Kommentar ist inhaltlich richtig, hat aber nichts mit dem Kommentar zu tun auf den geantwortet wurde.

Da bezweifle ich aber dass dieser Algorithmus dass immer und überall in jeder Situation zu 100% genau erkennt!

Wie sollte er auch. Das schafft auch kein Mensch, wenn du nur auf dieser Basis des einen Fotos eine Entscheidung treffen musst. Woher soll der Algo/Mitarbeiter wissen, ob es mein Kind ist?

Es gibt leider auch Eltern die ihr eigenes Kind missbrauchen. So einfach ist die Sache also sowieso nicht.

Das ist so nicht richtig: es gibt nämlich durchaus diese Graubereiche (Perspektive, Ausschnittvergrößerungen, etc.), in denen harmlos wirkende Bilder missbräuchlich genutzt werden. Die Frage wäre also: was guckt sich Apple an, wo zieht Apple Grenzen? Und erheben/sammeln sie Daten?

Ganz abgesehen von der prinzipiellen Kritik an Hintertüren!

Wenn ein solches Foto auf den Beschlagnahmten Gerät eines Pädophilen auftaucht, so wird es auch entsprechend markiert und der Algorithmus könnte bei ähnlichen Fotos anschlagen.

Es ist beides KiPo

Falsche Taste ;-)

Im „richtigen“ Kontext ist beides KiPo für die Ermittler.

Frag mal nach, wieso immer mehr Jugendliche in die Ermittlungen geraten.

Eine 12 jährige schickt ihrem 14 jährigen Freund ein Nacktfoto von sich. Er ist dran wegen Besitz, sie wegen Erstellung und Verbreitung von KiPo Material.

In Amiland landet er mit etwas Pech in der Liste der Kinderschänder, dann ist sein Leben vorbei.

Und laut dem Artikel und dem Beispiel oben muss das Bild nicht annähernd die gleichen Inhalte haben um falschpositiv zu sein.

Was hackt es denn?

Es muss eine ausreichende Anzahl an positiven Bildern im Account sein bevor ein Alarm ausgelöst wird.

Die Fehlerquote liegt laut Apple bei bei „eins zu einer Billion“ pro Jahr. Das ist schon ziemlich gut.

Dafür muss natürlich dein Foto zuerst von den US Behörden als Kinderpornografie erfasst werden.

Mal ganz davon abgesehen, warum man überhaupt Nacktfotos von seinen Kindern irgendwem schickt: Es werden nur Fotos gescannt, die in die iCloud Fotomediathek geladen werden sollen, oder per iMessage verschickt werden sollen.

Und natürlich nur, wenn Du einen US-Account hast.

Wenn das für die h ein Problem darstellt, deaktiviere iMessage und die Fotomediathek.

bitte noch mal lesen.

Tomw: Du irrst Dich. Es geht um Scans lokal auf den Endgeräten. Leider.

Nein eben nicht! Das ist das Problem.

Doch, es geht sehr wohl um Scans auf den Geräten:

„Überraschend hat Apple am Donnerstag über eine neue Initiative zum Schutz von Kindern informiert, die Fotos von mehreren hundert Millionen iPhone-Nutzern bereits auf deren Geräten scannen und lokal auf verdächtige Inhalte hin prüfen soll, noch bevor diese ihren Weg in Apples iCloud-Speicher antreten.“

Grundeinstellung iPhone? Jedes Bild geht in deine Cloud…

Er überprüft nicht das Bild, sondern gleicht es nur mit einer Datenbank ab, in der Bilder sind die als eindeutig mit Kindesmissbrauch gemeldet wurden. Und auch nicht direkt das Bild, sondern er generiert aus dem Bild einen anonymen Zahlenwert. Da wird ein Badezimmerbild nicht drin landen. Nochmal den Text genau durchlesen

Anst: Nicht korrekt. Siehe Artikel.

Bitte einfach mal die Doku lesen. Bilder werden nur vor Upload gescannt. Ohne aktivierte Cloud auch kein Scan. Und dann wird dafür eine Hash Datenbank genutzt in der einschlägige Bilder liegen. Private Fotos landen dort nicht, können also auch nicht gefunden werden.

Nein, Du irrst dich leider und verwechselst 2 unterschiedliche Funktion und vermischt den Auslöser einen Funktion und die Folge der anderen miteinander.

Wer oder was „hackt Apple“ denn?

0) Nachdem zunächst nur Bilder in der Cloud gescannt werden, wird das Verfahren auf alle Inhalte ausgeweitet. Sonst macht das ganze gar keinen Sinn.

1) Die Liste der Dinge, nach denen da gesucht wird, wird kontinuierlich erweitert. Anfänglich ist das Kinderpornografie – wie immer, wenn man einen möglichst breiten Konsens für neue Überwachungsmöglichkeiten braucht. Dann sucht man nach Terroristen, Menschenhändlern, Drogen-Dealern und so weiter und so fort. Das sind zumindest die vorgeblichen Ziele. Heimlich überwacht werden wir natürlich alle – ständig.

Anzeige

2) Staaten fordern und bekommen Einfluss auf die Suchkriterien und natürlich Zugriff auf die damit ausgelösten Alarme. Also nicht nur die USA und Deutschland. Sondern auch China, Russland, Ungarn, Belarus, Saudi-Arabien und so weiter. Schließlich müsse sich eine Firma doch an geltendes Recht halten. Und der Hersteller will natürlich weiterhin seine Gerätschaften verkaufen.

3) Andere Hersteller ziehen nach und bauen ähnliche Funktionen ein. Und irgendwann wird diese Form der Überwachung sogar vorgeschrieben. Und warum sollte man das auf Smartphones und Notebooks beschränken? Warum nicht auch Kameras und Spielekonsolen überwachen? Das komplette Internet der Dinge wird ein einziger Überwachungsalbtraum.

4) Es werden Möglichkeiten gefunden, das Suchverfahren zu hacken. Also gezielt Bilder oder Dokumente zu erstellen, die zwar eigentlich harmlos sind, aber trotzdem einen Treffer auslösen. Und die wird man Leuten unterjubeln, um diese zu diskreditieren.

Zitiert aus Heise

+1

+100

0: natürlich macht es Sinn, denn Apple ist nur verpflichtet Fotos in der Cloud zu scannen. Das Problem bisher war, dass die Fotos bei Apple (und MS, Google, Amazon, Dropbox) dort entschlüsselt, gescannt und wieder verschlüsselt werden mussten. Jetzt können die Fotos verschlüsselt übertragen werden, weil das vorher passiert.

Solange Apple nur lokal gespeicherte Fotos nicht scannt, ist das eine reine Unterstellung.

1: Das ist eine bloße Unterstellung. Wenn Apple verpflichtet werden sollte das zu erweitern, dann nur wenn alle anderen das auch machen.

2. Auch hier gilt, wenn alle Hersteller das machen müssen. Kein Land kann Apple allein dazu verpflichten.

3. Ja, das kann sein. Aber es laufen jetzt bereits Klagen gegen alle Hersteller, dass Sie nicht genug gegen Kindesmissbrauch unternehmen. Dass die Hersteller diese Technik implementieren können, wissen alle, somit hat es nichts damit zu tun, dass Apple das macht.

4. Das ist jetzt bereits möglich. Du sendest jemanden kinderpornografische Bilder mit einem Prepaid Handy und rufst anschließend die Polizei an.

+ 10

Stimmt 100%. Das schlimme daran ist, die meisten juckt es nicht. Man hat ja vermeintlich nichts zu verbergen.

Genauso, Kinderpornografie ist nur erstmal das Totschlagargument, damit alle anbeißen. Denn wer sollte schon etwas gegen den Schutz von Kindern haben? Klar muss man dagegen vorgehen, aber alle unter Generalverdacht zu stellen ist der falsche Weg.

Für Saudi-Arabien könnte ich mir schon eine Regenbogenflagge als Trigger für einen Alarm vorstellen. Willkommen im 21. Jahrhundert!

Simon: Genau das ist das Ziel. Aber den Leuten muss man nur etwas von Sicherheit erzählen und sie finden es ok.

Das Thema wird ja immer besser…

Ein krasser Wirbel!

Insgesamt hat es bei mir – überzeugter Apple User – sehr an dem Glauben und Überzeugung, wie auch Befürworter des Apple Ökosystems genagt.

In der Tat sehe ich hier mehr Nachteile als Vorteile. (das Potential, dass diese überschreitende Grenze zu Missbrauch genutzt wird)

Ich kann nur „an den Glauben“ hoffen, weiterhin bei Apple an der richtigen Stelle zu sein und dass es sich am Ende wirklich um Einsicht bzw. ein „Missverständnis“ handelt.

Sonst wird es wohl Zeit alternative Systeme anzuschauen, wenn es die denn gibt??

Vermutlich kommt es darauf an, dass sich auch genug Leute direkt bei Apple beschweren, und nicht nur hier im Forum zum Beispiel. Da packe ich mich nachher mal an die eigene Nase und schreibe Apple an. Ich habe gestern mit Techniker Kolleginnen und Kollegen darüber gesprochen und wir haben festgestellt, dass für uns der Wechsel des Betriebssystems fest steht, wenn das hier kommen sollte. Ich traure jetzt schon meinem iPad Pro, meine Apple Watch und meinem iPhone nach, falls das so kommen sollte, aber das ziehe ich durch.

Die Frage ist nur wohin geht man und ist es dort besser (in der Hersteller- und Betriebssystem-Welt)?!

Es ist immer eine Frage der Verhältnismäßigkeit. Und die ist hier einfach nicht mehr gegeben.

Keine bestreitet oder verneint den grundsätzlichen Sinn dahinter, aber die möglichen Nachteile sind halt riesig und sehr bedenklich. Es gibt sicherlich auch andere Möglichkeiten Kinderschänder zu ermitteln als alle unter Generalverdacht zu stellen.

+1

Ja…

Ich finde es grundsätzlich „schwierig“ das Apple und Google solch harte Scanning Prozesse implementieren. Das Problem: Wenn man sich öffentlich dagegen stellt, wird dies oft mit einem Führsprechen von solchen Inhalten gleichgestellt. Das jedoch damit das Tor für alles andere offen steht wird nicht bedacht. Auch Google scannt ja alles Mails auf Hash und betonte damals sogar, das selbst Mordkomplotte oder andere schwere Straftaten ignoriert würden…

Ich finde diese Entwicklung geht in eine Problematische Richtung.

Man erinnert sich da auch an die damaligen Aussagen von Siri Mitarbeitern die den ganzen Tag teilweise ganze Gespräche mitgehört haben.

War das Vorhaben der Abgesang vom großen Perrsönlichkeitsschutz? Hatte für mein 12er extra den größten Speicher für Fotos genommen-wird das letzte Mal gewesen sein. Die scannen meine Fotos???!!!

Das machen sie schon die ganze Zeit, oder was glaubst du, wieso du in der Foto-App nach gleichen Gesichtern oder Katzen suchen kannst? Dieser Algorithmus wird nun lediglich um einen Abgleich von Hashwerten in einer Datenbank ergänzt.

Lediglich ist gut… ein ziemlich schaler Kommentar, der an der Heftigkeit dieser Entwicklung total vorbeigeht. Auch wenn du technisch recht hast, aber das meinte der OP ja nicht.

Der Scan war aber bisher nur lokal und es gab auch keinen Rückkanal an Apple.

Das nun wirklich nicht was man vergleichen könnte

Langsam aber sicher entwickelt sich Apple genau zu dem bösen Onkel wogegen die Firma früher aufgelehnt hat. Ein Konzern der alles reguliert, vorschreibt oder einschränkt und um das alles schmackhaft zu machen werden die Menschen getriggert, wer ist schon dagegen das die Kinder besser geschützt werden sollen, Frage ist nur ob, dass der richtige Weg ist

Apple 1984

Ich sehe das genauso kritisch.

Auch ich werde jetzt ernsthaft nach Alternativen schauen für unsere Apple Geräte (2 Iphone/ 3 IPad / 2 Mac Mini / 2 Apple TV / 1 AirPod pro)

Die Vorteile des Ökosystems drohen in Nachteile über zu gehen. (Die Besen die ich rief)

Missbrauch von Kindern zu verhindern ist gut und wichtig, aber ggf. meine privaten Bilder mit einer manuellen Sichtung zu überprüfen eine andere…

So ähnlich war es bei der Siri Debatte, bei der Sprachkommandos und Gespräche durch Mitarbeiter analysiert wurden.

Wird doch jetzt schon gemacht, wenn Du eine Cloud verwendest. Und wenn nicht, ändert sich nichts, da nur Bilder, vor dem Hochladen in die Cloud gescannt werden.

Also viel Lärm um nichts!

Nicht korrekt, die Bilder werden lokal auf den Endgeräten gescannt. Offenbar auch ohne Nutzung der Cloud.

Heute sind es die KP und morgen eure Meinung! Oh du hast was gegen die Regierung, wie war das was du da geschrieben hast der President ( oder hier der Kanzler*in ) ist ein Stück schei… oh oh ab mit dir in den Knast du Terrorist. Sieht man an den Beispiel USA seit seit den anschlägen was sich da im Namen der Terrorismusbekämpfung alles geändert, vor allen für nicht Amerikaner.

Dass Apple schon immer seine Nutzer so lenkte, wie es der Firma passte, weiss ich seit meinem Umstieg vom DOS/ Windows-System zu Mac System 6.

Dass die Amerikaner nach aussen Prüde und insgeheim alles andere sind auch. Dasselbe Theater mit dem Alkohol.

Apple kann mir aber Zugriffe auf meine Geräte nicht ableugnen. Dass mit der scheinheiligen Begründung Kinder vor Missbrauch zu schützen der Zugriff zu mehr erweitert wird, Stufe ich als von Onkel Sam gewünscht ein. Apple will sich nur noch nach aussen absichern, falls es auskommt.

Wie ist das denn, wenn meine Fotos erst gar nicht in die iCloud geladen werden? Weiß das jemand?

Da die Analyse auf dem Gerät stattfindet, sollte das egal sein.

Und wie kommt Apple dann zur Sichtprüfung an das Bild auf meinem Gerät?

Indem das Foto an Apple übertragen wird. Da es auch keine Möglichkeit gibt einen Apple internen Prozess zu untersagen das er nicht in das Internet darf. Naja genau genommen kann man eh nur untersagen das mobil das Internet geblockt wird. Nervt mich

Einfach iOS 15 nicht installieren

Nach derzeitigem Stand findet die Sichtung durch Apple-Mitarbeiter „nur“ von iCloud-Bildern statt. Es sollen (auf dem iOS-Gerät) auch nur Hash-Werte von Bildern analysiert werden, die in iCloud hochgeladen werden …

Was wirklich kommt und wie es später womöglich erweitert wird, ist natürlich eine andere Frage.

Diverse Medien berichten das eine Prüfung nur bei aktiver iCloud Mediathek vor Upload stattfindet.

Phil: ja, darauf hatte ich in einem anderen Kommentar (ich glaube in dem Original Artikel) auch schon hingewiesen… Die EFF hatte das glaube ich genauso formuliert, wie du schreibst. Wenn das Scannen „nur“ die iCloud beträfe, würde sich zum Beispiel für mich persönlich nichts ändern müssen, da ich diese nicht für Fotos nutze – aus gutem Grund, siehe oben. Es bleibt spannend…

Apple durchlöchert gerade sein Privatsphäre-Versprechen indem es zum schnüffeln eine Backdoor in sein System baut: https://thenextweb.com/news/apple-csam-scanning-experts-concerns-analysi/amp Wenn die Technik vorhanden ist, kann man damit ALLES abgreifen. Und ausgerechnet die Krake Whatsapp lässt schon verlauten, dass sie nicht scannen wird. Apple Geräte sind für mich gerade ein gutes Stück unattraktiver geworden. Und iCloud Photos habe ich schon ausgeschaltet.

Hier widerspricht sich aber was – wie will Apple bei angeblich vollverschlüsselten Bildern eine Sichtkontrolle durch Mitarbeiter veranlassen?

Bei auffälligen Hash-Werten wird Apple vermutlich das Recht haben entsprechend eine unverschlüsselte Version des Bildes abrufen zu können.

Die Doku hilft. Es gibt diverse Layer Verschlüsselungen um sicherzustellen das nicht unberechtigt Bilder entschlüsselt werden können. Steht alles in den PDFs.

Digitales 1944 kommt

Nun ja, die Kamerahersteller werden sich freuen. Leute kaufen wieder separate Kameras um ihre Fotos zu machen.

Apple ist so lächerlich geworden.

Jetzt sind auf einmal die Kunden die Dummen, die alles missverstehen? Wenn die Kinder jetzt plötzlich so wichtig für Apple geworden sind, frage ich mich, was mit den Leuten ist, die den ganzen Tag iPhones zusammenbauen?

Sind die egal, trotz der schlechten Arbeitsbedingungen? Typisch Apple. Ein auf scheinheilig tun, aber selber Dreck am Stecken haben und den verbergen.

Missverständnis….!! Tim Cook würde ich sehr gerne mal begegnen!

Gegen Kinderarbeit wird bei Apple Zulieferern doch schon ewig vorgegangen. Wo ist also das Problem?

Das Problem ist, dass vielen offenbar der Grund „Kinderschutz“ vorgeschoben erscheint.

Wer glaubt bei den anderen Handyherstellern wäre es besser, dem sollte man mit auf den Weg geben, dass die sich ja bisher nicht geäußert haben ob das dort auch ins Auge gefasst wird.

Und wer wirklich glaubt das nicht überall BigBrother ist, dem ist nicht zu helfen.

Solange niemand sagt das etwas gemacht wird ist alles in Ordnung. Sobald jemand sagt das irgendwo ein Scan gestartet wird, kommen alle aus den verstecken hervor und beschweren sich.

Was hilft es, auf andere zu deuten? In diesem Fall geht es um Apple.

Weil überall gespäht wird.

Aber Apple ist der Konzern der sich für Privacy ausspricht und das dann auch zu tun hat. Dieses Argument das es alle machen, sorgt dafür das es auch immer weiter geht.

Weil die Alternativen fehlen, außer man verzichtet insgesamt auf Smartphone und co.

Es ist kein einziger Hersteller bekannt der Bilder scannt! Apple macht es vor alle anderen werden folgen.

Also kann sich apple einfach fotos von deinem iphone schnappen und ansehen.. sehr bedenklich

Nein. Nicht mal wenn ein Alarm ausgelöst wird können beliebige Bilder „geschnappt“ und angeschaut werden. Hier hilft echt mal die Dokumentation dazu zu lesen.

Nein, nur wenn Du Fotos in die Cloud laden willst. Aber das ist bei allen Cloudanbietern so, die scannen die dann in der Cloud

Offenbar nicht korrekt, Deine Aussage. Scheinbar soll direkt auf den Geräten auch gescannt werden, nicht nur in der Cloud.

Der Scan wird dann auf dem Gerät ausgeführt, wenn die Cloud Mediathek aktiviert ist und somit vor Upload. Es gibt keinen proaktiven Scan ohne das die Fotos eh in der Cloud landen, wo sowieso jeder Anbieter seit Jahren jedes Fotos scannt. Hier wird der Schritt dann nur aus Datenschutzgründen auf das Gerät vorgelagert. Es ist und bleibt also ein Stürmchen im Wasserglas weil egal ob die Bilder bei Big A, Big G oder sonst wo liegen, richtigerweise wird dort sowieso gescannt.

Nach DSGVO muss (!) der User demnach zustimmen. Also hoffe ich, dass zumindest die EU das als Pflicht einführt und uns dieser Mist erspart bleibt. An und für sich heiße ich es gut, allerdings nicht die Sichtung meiner Bilder und vor allem nicht ohne mein Einverständnis.

Frage mich allerdings auch, ob so viele Pädos Apple nutzen, dass sie sich dazu genötigt fühlen…

Wenn dem ganzen zugestimmt werden muss ergibt es überhaupt keinen Sinn mehr.

Es sollten vielleicht auch einfach die Geräte gescannt werden, die eben ablehnen. ;) Denn bei denen ist es wohl am spannendsten.

Nein. Nur weil ich Privatsphäre haben will, heißt das nicht, das ich verdächtig bin. Mit diesem Argument spielst Du Apple und insbesondere den Behörden nur in die Hände. Privatsphäre ist ein Menschenrecht.

Bob.

Das beharren auf Grund – und Menschenrechte ist mittlerweile mehr als nur verdächtig.

Ich bin sicher das wir dem zunächst unsere Zustimmung erteilen müssen.

Machen wir aber auch: bei der Inbetriebnahme eines Gerätes erklären wir doch als erstes unsere Zustimmung zu den Bedingungen der Nutzung.

In sofern, darfst du wohl annehmen das wir alle diese Zustimmung direkt erteilt haben werden.

Bzw. die Frage ist ob Apple die Anzahl an „Pädos“ als Nutzer ausreichend klein einschätzt, dass sich diese in den zahlen nicht merklich widerspiegeln….

Apple soll also keine Probleme angehen weil sie selbst nicht alles richtig machen. Wie das Problem angegangen wird ist sicherlich diskussionswürdig. Es gar nicht zu tun ist es nicht. Und zum Thema Kinder müssen unter beschissenen Bedingungen irgendwelche Arbeiten verrichten: Solange wir die Scheiße mit unseren Käufen unterstützen und weiterhin allen Dreck kaufen, den wir zum Leben nicht unbedingt brauchen und dass auch noch zu Preisen, die Fairtrade unmöglich machen, brauchen wir uns NULL beschweren.

Das ist ein Trugschluss. Nicht der Käufer oder der Hersteller ist verantwortlich für die Arbeitsbedingungen in den jeweiligen Ländern, sondern diese Länder selbst sind verantwortlich. Was hindert sie daran, Arbeitsschutzgesetze zu beschließen oder Gewerkschaften aufzubauen? Wer hat die Europäer dabei unterstützt? Aber ich weiß schon, Eigenverantwortung ist heute nicht mehr en vogue.

Was sie daran hindert? Wir. Solange wir mit unseren Käufen unterstützen und der ständige Preisdruck dazu zwingt in diesen Ländern zu produzieren, wird es so bleiben…

Ich frage mal anders was würde passieren wenn der selbe Fernseher auf einmal durch fair trade 3000€ statt 500€ kosten (fiktive Zahlen). Keiner würde die Dinger mehr kaufen oder nur noch wenige. Ich verkaufe Fair Trade Geräte… kein Mensch will die. Man bekommt von den „bösen“ Unternehmen günstigere Geräte mit mehr Leistung. Die Leute kaufen nur sowas.

Warum kaufst du denn Produkte von Firmen bei denen die Produktionsbedingungen scheiße sind? Den meisten Menschen ist es wichtiger etwas zu besitzen als zum wohle anderer daruaf zu verzichten. Das kann aich jeder gerne so tun wenn es für das richtige gehalten wird. Nur dann mit dem erhobenen Zeigefinger dazustehen und den Moralapostel zu spielen ist heuchelei Level 9000

So so, also immer sind „wir“ schuld und halten die anderen für zu dumm, an dem Zustand etwas zu ändern.

Genau das ist doch das was ich kritisiere! Wir suchen die Fehler bei anderen und nicht bei uns. Das ist genau das was ich geschrieben habe.

Du hast argumentiert „die länder müssen was tun“ also die anderen aus deiner Position.

Selbst überführt würde ich sagen.

Es ist doch mit so vielen Sachen so, dass wir uns selbst verarschen. Die meisten Menschen sagen auch, die Tierhaltung in der Industrie ist scheiße. Kaufen aber an der Kühltheke das billigste Fleisch auf den 1000€ Webergrill (ist der eigentlich fair trade?) Es ist doch also nachvollziehbar, dass die Industrie gezwungen wäre, die Billigfleischproduktion fallen zu lassen, wenn jeder nur noch teureres Fleisch kauft, bei dem sichergestellt wurde, dass die Tiere gut gehalten worden sind. Folglich würden sich doch auch die Produktionsbedingungen in der Techindustrie verbessern, wenn jeder die Firmen boykottiert, bei denen Kinder mit Säuren das Silizium aus unseren alten Motherboards holt. Also bin ich/wir als Käufer das Problem. Und wenn sich bei mir als Käufer, der Wunsch nach Konsum nur immer mehr verstärkt (was ich durch mein Kaufverhalten deutlich signalisiere), rufe ich doch alle Unternehmen dazu auf so zu agieren. Es gibt Studien darüber, dass Menschen zwar genau wissen was getan werden sollte, in einer Situation in der das relevant wäre aber immer die falschen Entscheidungen treffen. Erst letztlich gab es hier einen Bericht über eine solche Beobachtung bei Zalando. Käufer gaben an, dass ihnen Nachhaltigkeit und faire Arbeitsbedingungen wichtig ist, kauften dann aber die Waren die dies nicht gewährleisteten obwohl ihnen eine faire und nachhaltige Alternative aktiv angeboten wurde. Wollen wir weiter machen mit Milchbauern? Dass wir uns über einen Preisanstier von 5cent beschweren damit beim Bauern etwas mehr hängen bleibt? Wollen wir über den Lithiumabbau für Elektroautos sprechen? Wollen wir darüber einen Dieselskandal bei VW sprechen und die Gewinne des Konzerns daneben legen?

Wenn wir uns über irgendwas aufregen, dann sollte man immer erstmal gucken wie man selbst zu diesen Problemen beiträgt und an sich selber arbeiten. Selbst wenn es kein anderer tut.

Ich verstehe dich aber auch. Natürlich muss es für Firmen globale Regeln und auflagen geben. Damit ließe sich schon einiges lösen (sofern sich dran gehalten wird) ich glaube nir noch mehr daran, dass die sich erst drehen, wenn die unser Geld nicht mehr bekommen. Im Falle Apple regen sich hier jetzt viele auf, kaufen das iPhone 17 aber trotzdem. Würden sie es alle nicht mehr tun, wäre Apple im Zugzwang. Kausalität is real.

Wer bis hier hin gelesen hat: RESPEKT

Sorry, da kommen wir nicht überein. Die Politik ist dafür verantwortlich, entsprechende Regeln festzulegen. Freiwilligkeit funktioniert nicht. Der Mensch ist egoistisch. Und zwar jeder einzelne.

Dann hoffe ich, dass die Politik unser Verhalten so deutet, dass sie sich im Zugzwang steht und wirtschaftliche Interessen nicht mehr prio 1 in allen Fragen bleibt.

Kein Käufer ist verantwortlich für die Herstellungsbedingungen eines Produktes.

Es ist nichtadlige Aufgabe von Apple oder einem anderen Konzern gegen strafbare Handlungen vorzugehen. Es ist die Aufgabe der entsprechenden Behörden.

In Zeiten, wo wir fordern Bilder von Hr Rubens aus den Museen zu verbannen in die Kinder in der Schule nicht mehr von den „Newtenschen“ Gesetzten zu sprechen, bin ich gespannt was morgen kommt und mache mir Sorgen was ich vor 15 Jahren gemailt, gechattet oder am Telefon gesagt haben könnte.

Was bitte spricht gegen die Newtonschen Gesetze? Und wie sollen sie jetzt angeblich heißen?

Keyword Cancel Culture/ decolonize

the three fundamental laws of physics

Ich bin zwiegespalten: ich bin Vater von zwei kleinen Kindern. Sicherheit und Datenschutz darf aus meiner Sicht nicht das wichtigstes Attribut sein und vor allem nicht die Strafverfolgung behindern. Apple, Google etc. sind m. E. zurecht einem gewissen Druck der Behörden ausgesetzt. Die Funktion von Apple bietet eine Lösung unter Berücksichtigung des Datenschutzes zum Schutz unserer Kinder. Wenn wir möchten bzw. erwarten, dass Täter zur Rechenschaft gezogen werden, dann müssen wir zu gewissen Kompromissen bereit sein. Irgendeine Lösung muss es geben. Für mich ist es wie so vieles ein gesellschaftliches Thema.

Grundsätzlich richtig ist es unsere Kinder zu schützen, aber der Gedanke ist zu kurz gedacht, die Probleme, die es nachzieht sind weitaus größer und gefährden die FREIHEIT jedes Menschen!

Der verlinkte Blog Beitrag ist mir zu schwammig und sollte ohne Prüfung der Aussagen nicht so stehen bleiben. Es ist immer noch vom Schwellenwert abhängig, wann das System einen Match findet. Bei einer niedrigen Schwelle kann ich auch bei Apfel und Birne einen Match bekommen. In der Dokumentation wird aber von einer Schwellenwahrscheinlichkeit von 1 zu 1 Trillion gesprochen.

Ich finde einige Kommentare echt peinlich. Das scannen der Fotos ist auch Standard bei anderen Cloud Anbietern. Sie werden nicht gescannt, wenn ihr die Fotos lokal speichert. Bei den andern Herstellern wird der Scan auf den Servern ausgeführt und nicht auf dem Gerät.

Falsch!

Ne richtig

Wie traurig ist es das Apple auch nur darüber nachdenkt.

Menschen haben Ihr Leben riskiert um darauf aufmerksam zu machen wie Algorithmen heute schon in unser Leben eingreifen.

Ein Konzern der sich zu „Privacy“ verpflichtet glaubt „ernsthaft“ das diese Idee – in welcher Form auch immer – akzeptabel ist? Es ist lächerlich den Vorwand der Kinderpornographie zu bringen. Wieviel % unserer Gesellschaft haben wohl diese krankhafte Einstellung um es als Grundlage zu nehmen für eine totalitäre Überwachung eines Technikkonzerns.

Noch vor ein paar Jahren hat man sich darüber unterhalten das über Alexas und Homepods in unsere Haushalte hinein gehört wird. Wenn man jetzt bereit ist, das sich Apple Mitarbeiter unsere Fotos ansehen, verstehe ich die Welt nicht mehr.

Wir reden von einem Hersteller von Telefonen und Computern der sich bemüht auch Services zu verkaufen. Wir reden nicht von einer Regulierungsbehörde oder von einem Gesetzgeber.

Armer Apple Konzern, hier gehst Du sehr weit über das hinaus was man Kernkompetenz nennen sollte. Und ganz sicher weit von dem entfernt, was ein Steve Jobs als Intention hatte. Und das muss ich heute sagen, als sehr treuer Kunde dieses Konzern.

Es sind schon viele große Unternehmen gestorben, die von sich glaubten das dies nie passieren könnte. Auch Nokia und Microsoft sind heute im Mobiltelefonmarkt nur noch eine Anekdote. Und von meinem sehr guten Nokiatelefon habe ich mich damals auch getrennt, weil man die Zukunft nicht erkannte.

Also hoffen wir mal, das Apple nicht Zeit darin investiert uns erklären zu wollen wie toll diese neue Möglichkeit ist. Die Zeit ist besser investiert Schadensbegrenzung zu betreiben und die Marketingabteilung zu nutzen um zu erklären das es eine unglückliche Idee ist und völlig gegen die eigenen „Privacy“-Richtlinien spricht.

Exakt das was ich denke. Sehr enttäuschend!

Was ich nicht verstehe bei den ganzen Wirrwarr. Werden nun die Fotos auf iCloud oder auch die auf den Geräten durchsucht?

Eigentlich ganz einfach: jedes Foto in der Cloud (egal bei wem es liegt) wird seit Jahren gescannt – genauer jedes Bild das irgendwie über irgendeinen einen Server läuft (verschicken per Mail zum Beispiel).

Apple führt jetzt einen Scan vor Upload durch, also vor Verschlüsselung. Bleiben die Bilder lokal, weil kein Cloud Sync durchgeführt wird, wird auch erst mal nichts gescannt so wie es jetzt heißt.

Genau so ist es. Anscheinend haben das wirklich viele nicht verstanden.

Hier muss man aber auch die Medien inkl. ifun.de kritisieren, dass das nicht mal richtig klargestellt wird.

Aber dann erzeugt man natürlich auch nicht so viele Klicks und Kommentare.

Für Europäer ändert sich rein gar nichts. Für US Bürger wird der Scan vor dem Hochladen in die Cloud durchgeführt, statt bei Ankunft.

Den iMessage Filter für die Kinder finde ich sehr gut und sollte auch in der EU eingeführt werden. Es ist nämlich unfassbar, was Kinder für Nachrichten geschickt bekommen.

Da fehlt doch etwas die Weitsicht!

Wenn iCloud das sowieso alles scannt wenn es hochgeladen wird, warum soll es dann auf DEINEM Telefon lokal nochmals passieren? Dafür gibt es überhaupt keinen Grund.

Ausser das dein Telefon jetzt über eine Funktion verfügt die in Zukunft ALLES mögliche scannen kann, nicht nur KiPo.

Und das es in Europa keine Auswirkungen hat glaubst Du ja wohl selber nicht mit Zensursula als aktuelle EU_Vortänzerin. Die wartet da schon sehnsüchtig auf sowas.

Und dann, was soll das ,den Mist dann an eine NGO weiterzumelden, anstatt der Staatsanwaltschaft? Haben die USA ihr Rechtssystem schon komplett privatisiert?

Deine Kinder schützt Du am Besten wenn Du ihnen eine gewisse Medienkompetenz beibringst und das nicht einem amerikanischen Konzern überlässt.

Die Medien haben das ganze Thema im übrigen allesamt korrekt wiedergegeben, mann muss nur richtig lesen und verstehen (gehört auch zur Medienkompetenz).

Also wenn du iCloud Fotos nutzt, dann wird vor dem Upload die Bilder in Hashwerte umgewandelt und mit einer Datenbank von mehrere Organisationen gegen Kindersmissbrauch verglichen. (Gilt nur in den USA, weil Apple hier schon öfter verklagt worden ist) Das passiert alles lokal auf dem Gerät. Diese Hashwerte sind Verschlüsselt und können nur bei Treffer entschlüsselt werden.

Zur EU….auch wenn hier soviel TamTam um DSVGO gemacht wird, für Apple macht dann die EU eine Ausnahme….ist ja für eine gute Sache! Ich kann nur sagen: wehret den Anfängen….also keinen Scan auf meinem Gerät!

Wow, ist wie in einem schlechten Film. Selten so ein Blödsinn von Apple gehört und gelesen. Eine Datenbank die veraltet ist schützt Kinder doch null.Der Missbrauch ist ja dann längst passiert. In welcher Weise schützt es denn Kinder? Als die Kopiergeschützten Filme und Musik rauskamen hat es die Menschen trotzdem nicht aufgehalten illegales Material zu konsumieren. Ich frage mich wer dümmer ist, Apple oder die KP Konsumenten. Was macht der Mensch wohl mit solchen wiederkommen Neigungen? Er kramt sein altes iPhone raus und schaltet das Internet. und dann Apple? Ich behaupte mal dass keiner von dieser Vollpfosten solch brisantes Material lokal auf deinem Smartphone hat wenn man weiß das Spotlight bereits die Bilder gut mit Stichwörtern und sogar Gesichtsanalysen markiert. Somit glaube ich Apple kein Wort. Mit welchen Geräten werden denn die Missbrauchfotos gemacht? Sollte man da nicht reaktiv handeln wenn das Bild gemacht wird? Apples KI ist für die Tonne was man täglich an Siri sehen kann. Und auch hier werden Menschen einfach händisch unsere Fotos nach Belieben durchsuchen. Sollte gerade vielen Politikern und Promis auf den Magen schlagen wenn wildfremde intime Einblicke in ihr privatestes bekommen. Ich beneide jetzt schon den Typen der die ganzen unverhüllten Nacktbilder von Heidi Klum sichten darf die es nicht auf Instagram geschafft haben. Wenn wir Glück haben wird Apple mal gehackt und wir kommen auch in den Genuss.

Ich bin zwiegespalten: ich bin Vater von zwei kleinen Kindern. Sicherheit und Datenschutz darf aus meiner Sicht nicht das wichtigstes Attribut sein und vor allem nicht die Strafverfolgung behindern. Apple, Google etc. sind m. E. zurecht einem gewissen Druck der Behörden ausgesetzt. Die Funktion von Apple bietet eine Lösung unter Berücksichtigung des Datenschutzes zum Schutz unserer Kinder. Wenn wir möchten bzw. erwarten, dass Täter zur Rechenschaft gezogen werden, dann müssen wir zu gewissen Kompromissen bereit sein. Irgendeine Lösung muss es geben. Für mich ist es wie so vieles ein gesellschaftliches Thema.

Wer bewirbt sich denn bei Apple auf einen Job um den ganzen Tag Kinderpornos zu schauen? Dass sowas von Apple auch noch entlohnt wird…

Jedenfalls besser als wenn die Treffer alleine entscheiden würden.

Das machen bei uns in Deutschland Polizisten, die dafür schlecht bezahlt werden und psychische/seelische Schäden davon tragen. Sie machen es aber trotzdem, weil sie unsere Kinder schützen wollen vor diesen schrecklichen Menschen, die nicht immer krank sind, sondern damit einfach nur Geld verdienen wollen.

Grundsätzlich gehört da m.E. dann aber auch eine entsprechende Prüfinstanz hin. Und nicht an einen vermutlich unterbezahlten Apple-Mitarbeiter der von der Hotline versetzt wurde und nebenbei noch Siri-Mitteilungen anhören muss. Und da der Polizei das nicht auch noch zusätzlich aufgelastet werden kann ist das Konzept so m.E. noch nicht marktreif.

Es ist nicht mehr weit mit dem chinesischen Vorbild der Fussgängerüberwachung und öffentlicher Auswertung über vermeintliche Gesetzestreue.

Das gibt es ja jetzt schon durch CCTV in China. Auf 2 Bürger kommt eine Kamera. Und die Daten liegen schon in Staatlichen Apps.

Vielleicht werden wir durch die vielen chinesischen Produkte, die wir alle kaufen und mit dem Internet verbinden, schon lange viel krasser überwacht und irgendwie dadurch von China aus gesteuert!?!

Ich bin zwiegespalten: ich bin Vater von zwei kleinen Kindern. Sicherheit und Datenschutz darf aus meiner Sicht nicht das wichtigstes Attribut sein und vor allem nicht die Strafverfolgung behindern. Apple, Google etc. sind m. E. zurecht einem gewissen Druck der Behörden ausgesetzt. Die Funktion von Apple bietet eine Lösung unter Berücksichtigung des Datenschutzes zum Schutz unserer Kinder. Wenn wir möchten bzw. erwarten, dass Täter zur Rechenschaft gezogen werden, dann müssen wir zu gewissen Kompromissen bereit sein. Irgendeine Lösung muss es geben. Für mich ist es wie so vieles ein gesellschaftliches Thema.

Das bedeutet aber auch, dass an jeder Kreuzung oder alle 100 Meter ein Blitzer aufgestellt werden sollte, sonst kann man ja die Geschwindigkeitsübertretung nicht überwachen. Es geht ums Prinzip und Verhältnismäßigkeit. 1,5 Mrd OS Geräte überwachen, weil 1.000 Geräte strafrechtliches Sharen?!? Das ist purer Wahnsinn.

Völlig falsche Richtung und ich überlege gerade ernsthaft mein iCloud Abo zu kündigen und doch wieder auf komplett lokale Speicherung zu setzen. iCloud Fotos sind natürlich auch jetzt schon nicht privat….da sie nicht Ende zu Ende verschlüsselt sind, kann Apple natürlich auch aktuell schon sämtliche Bilder einsehen. Auch wenn ich mir eigentlich eine komplette E2E Verschlüsselung der iCloud Inhalte wünsche, bin ich aber bereit diese Kröte zu schlucken, denn ich will meine Bilder gut gesichert vor Verlust wissen.

Das Apple nun aber anfängt nicht nur in der Cloud sondern auch noch lokale Bilder zu prüfen und diese bei Verdacht sogar von Menschen prüfen lassen will, bringt für mich das Fass zum überlaufen.

Apple Fotos mit lokalem Sync oder über die private Nextcloud würde ich sofort vorziehen….

Doch, die sind E2E verschlüsselt. Das betrifft aber nur die Übertragung. Am „Ende“ (icloudserver / dein idevice) wird die Übertragungsverschlüsselung aufgehoben, und die geräteverschlüsselung greift. Deshalb kann jemand, der den Schlüssel für die Übertragung hätte, deine Daten auf dem idevice nicht sehen, weil die anders verschlüsselt sind. Selbiges auf icloud. Problem: Apple hat den Schlüssel für die Daten die auf icloud parkiert sind. Ja, sie sind verschlüsselt, aber ja, sie können sie jederzeit aufmachen.

Nein, Apple durchsucht nur die Fotos, die in die Mediathek hochgeladen werden sollen. Für dich ändert sich nichts.

Auch hier die Bitte um eine verlässliche Quelle. Bislang sieht es so aus, dass definitiv auch aus auf den Geräten gescannt werden sollen, zumindest war dies der Tenor.

Da wurde eine wunderbare PDF Dokumentation veröffentlich. Kann jeder lesen. Die erklärt alles ausführlich.

@Ute:

https://www.apple.com/child-safety/

„CSAM Detection enables Apple to accurately identify and report iCloud users who store known Child Sexual Abuse Material (CSAM) in their iCloud Photos accounts.“

Die Ignoranz von Apple ist echt grenzenlos!!!!

Ich frage mich auch ernsthaft was dieser Ansatz von Apple bringen soll….Welcher Idiot würde solche Bilder und Videos denn unverschlüsselt in seine normale Foto Mediathek packen?

Hatten nicht sämtliche bisher hochgenommene Kinderschänder Ringe diese Daten stark verschlüsselt und teils sogar auf eigener Server Infrastruktur liegen? So wurde es zumindest häufig in den Medien suggeriert…..

Ich habe es satt, dass ein Konzern wie Apple sich echauffiert zu wissen, was gut und für uns Bürger ist und was nicht. Ich bin auch vollkommen gegen Kinderpornografie. Aber das geht mir eindeutig zu weit.

Niemand hat recht dazu, in meinen Fotos rumzuscannen. Ein weiterer Grund, warum ich iCloud meide und lieber darauf hoffe, dass das nächste iPhone mehr Speicher hat.

Ja nur gut dass die Funktion Lokal auf den Geräten ausgeführt werden soll.

Nur bei aktivierter Cloud Mediathek. So what?

Phil: Du hast zumindest technisch in diesem Fall recht. Es werden erstmal nur Fotos gescannt, welche in irgendeiner Weise das Gerät über das Internet verlassen sollen. Es soll also geprüft werden, wer was teilt und ob das „illegal“ (abhängig vom Land) ist. Soweit so gut.

Die Sorge der meisten Leute hier ist aber eine andere, eine Projektion der zugrunde liegenden Technologie. Denn keiner weiß, was in der Hash-Datenbank liegt, und Apple sagt eindeutig in dem Dokument aus, das kein User wissen soll was in der DB liegt! Hier ist das Problem! Die DB kann jederzeit angepasst und geändert werden und du stimmst zu das du keinen Einblick hast nach was gescannt wird! Derzeit spricht jeder von KP, was ist im Winter? Nächstes Jahr? Wie entwickelt sich die DB? Wie entwicklet sich die Neural-Engine?

Es geht darum, dass hier ein erster fundamentaler Schritt zur Analyse von Nutzerinhalten gemacht wird, bei dem externe Dritte vorgeben, nach was gescannt wird. KP ist dafür natürlich, genau wie Terrorismus, die beste Wahl, wenn man sowas starten möchte. Die Geschichte zeigt zu 100% immer das gleiche Bild: Wo solche Wege erschlossen wurden, da wurden sie auch mißbraucht. Immer. Das wird hier nicht anders sein.

Verbindliche Quelle, daß das nur für iCloud-Geschichten angewandt werden soll?

Offizielle Webseite.

Und wie lange bleibt das so?

@Ute:

Bitteschön

https://www.apple.com/child-safety/

Das entscheidende Problem ist ja nicht, dass die Fotos gescannt werden (wie es bei Online-Diensten üblich ist), sondern – soweit ich es verstehe – dass die „Scan-Function“ ins iPhone (bzw. Device/Client) verlagert wird und damit Tor und Tür offen sind für die Kontrolle aller Inhalte auf dem Gerät. Da hilft m.E. kein Klagen, sondern nur die freie Tat: aufs iPhones zu verzichten – das mag zwar schmerzhaft sein, aber wem der Datenschutz wirklich am Herzen liegt, hat wohl keine andere Wahl.

Könnten Apple nicht nun eigentlich, gerade in Amerika, auf mehre Milliarden von allen Usern verklagt werden? Denn eigentlich sagen sie ja erstmal, Ihr seit alles Pädophile und deswegen überprüfen wir euch nun.

Umgekehrt ist es so. Apple wurde verklagt nicht genug zum Schutz vor Kindesmissbrauch unternimmt.

Wenn auch nur einen 1 % der betroffenen Kindern dadurch geholfen werden kann ist das wichtiger und richtiger als das große Überwachungsmimimi!

Bei solchen Kommentaren dreht sich mir echt der Magen um …

Ganz toll… der Zweck heiligt NICHT die Mittel. Aber du bist sicher einer, der sein Haus bei Streetview verpixeln lässt oder was? Du hast ja nix zu verbergen…

Es geht nicht darum das Kinderschänder gefasst werden – es geht um die Implementierung einer solchen Technologie im Allgemeinen – kann theoretisch auch für ganz andere Zwecke genutzt werden. Und wärest du damit einverstanden, wenn dein iPhone und Homepods, Macs und iPads alles aufzeichnen was gesprochen wird und verdächtige Worte und Sätze weiterleitet? Anscheinend. Weil du hast ja nix zu verbergen.

Und was ist mit den 100% die durch den Missbrauch dieser Technologie in totalitären Regimen dann zukünftig staatlichen Repressalien ausgesetzt werden könnten?

Wenn Apple sagt, dass man die rechtlichen Bedingungen vor der Einführung in weiteren Staaten prüfen werden, wissen wir doch alle, was das bedeutet: China muss nur das passende Gesetz erlassen und schon wird Apple wie immer Gewehr bei Fuß stehen und brav nach Winnie Poo Memes auf den iPhones chinesischer Nutzer suchen.

Es ist völlig egal, wie gut gemeint und durchdacht diese Hintertür heute ist. Es ist eine Hintertür direkt in die Geräte der Nutzer die früher oder später zu ganz anderen Zwecken genutzt werden wird.

Vor ein paar Jahren hat Apple selbst noch so argumentiert, jetzt haben sie die Tür selbst weit aufgestoßen…

Im Jahr 2020 wurden ca. 245 Menschen in D. ermordet. Ich verlange von dir die komplette Offenlegung all deiner Kommunikation, deiner Finanzen, deiner Kontakte und deiner kompletten Bewegungen mit Fahrtenbuch. Außerdem bekommst du eine Chip implantiert und ein Senderhalsband! Und Mikrofone und Kameras in deiner Wohnung gibts auch. Du hast ja nichts zu verbergen.

Wenn dadurch nur einer dieser Morde verhindert werden könnte, dann ist es das doch Wert oder? Etwa nicht? Wie? Du nimmst also den Mord eines Mitbürgers in kauf? Was für ein Mensch bist du denn? Also poste bitte hier deine Adresse, damit ich weiß wo ich das Team hinschicken muss.

Es ist nicht so, als ob das etwas beim Datenschutz bei Apple ändert. Apple gibt der Chinesischen Regierung vollen Zugriff auf alle Icloud Accounts und Inhalte. Wenn jetzt noch die komfortable Suche z.B. nach Bilder hinzukommt, wird das die Chinesische (und ungarische, und russische, und belarusische..) Regierung sicher erfreuen, dann kann man z.B. Bilder von Demonstranten ganz einfach durch Apple scannen lassen, was als Service sicherlich Umsatz bringen wird.

Ich empfinde den Missbrauch von Kindern als das schlimmste Verbrechen, dass man sich vorstellen kann, bin aber der Meinung das nicht jeder Apple User unter Generalverdacht stehen sollte.

https://www.wiwo.de/technologie/wirtschaft-von-oben/wirtschaft-von-oben-107-apple-hier-ueberlaesst-apple-die-daten-seiner-nutzer-dem-chinesischen-staat/27211788.html

Für mich ist es – wie so vieles – ein gesellschaftliches Thema. Die Kernfrage ist doch ob wir als Gesellschaft befürworten, dass Täter iOS Geräte zur Aufzeichnung und/Speicherung/Verbreitung von solchen Straftaten nutzen. Wenn wir das mit Nein beantworten braucht es irgendeine Art von Überprüfung. Diese kann nicht zu 100% datenschutzkonform sein. Das sollte uns bei dieser Diskussion klar sein. Apples Lösung ist ein möglicher maschineller Ansatz bei der erst im äußersten Verdachtsfall jemand Bilder zu Gesicht bekommt. Ich bin Vater von zwei kleinen Kindern. Sicherheit und Datenschutz darf aus meiner Sicht nicht das wichtigstes Attribut sein und vor allem nicht die Strafverfolgung behindern. Apple, Google etc. sind m. E. zurecht einem gewissen Druck der Behörden ausgesetzt. Wenn wir möchten bzw. erwarten, dass Täter zur Rechenschaft gezogen werden, dann müssen wir zu gewissen Kompromissen beim Datenschutz bereit sein. Ich finde Angst ist hier der falsche Ratgeber! Wenn auch sicherlich ein schneller Grad, das ist mit klar.

Das ist echt heftig. Ich kann mir garnet vorstellen das Apple sowas umsetzen will. Unfassbar.

Geht es wirklich um den Schutz der Kinder, oder möchte Apple ein System etablieren, dass für totalitäre Staaten interessant ist? Wäre es nicht möglich, dass unsere Kinder nur vorgeschoben werden, um alle Menschen perfekt überwachen zu können. In China ist man da ja schon sehr weit.

Immerhin ist Apple so nett, anzukündigen, dass iOS15 quasi „trojanerverseucht by design“ ist, weil es eine Schnüffelsoftware enthält, die die Privatsphäre missachtet, eine Steilvorlage für Überwachungsstaaten bietet und vermutlich nebenbei auch den Akku leersaugt.

Also erst mal Autoupdate bei iOS deaktivieren und lieber kein iPhone 12s/13 bestellen, falls die Datenschutzbehörden den Spuk nicht schon vor dessen Erscheinen austreiben.

Kinderpornographie zu bekämpfen ist wichtig. Aber der Zweck heiligt nicht die Mittel.

Aber das passt doch in eine Zeit der hysterischen Hexenjagd auf alles… wehe man gendert nicht, wehe man sagt “ Indianer“ oder man verkleidet sich oder gar seine Kinder als solche, wehe man zitiert „Neger“ und kürzt das Wort nicht ab, wehe man kritisiert die Massnahmen für ein omminöses, kaum vorhandenes „drittes Geschlecht“, wehe man ist nicht irgendwie „links“, wehe man hört Viking-Metal… und schwups, schon bin ich ein böser Nazi.Und jetzt noch ein Kinderschänder wenn ich diesen Unsinn von Apple nicht will. Also bin ich jetzt ein rechter, pädophiler Neonazi. Nun – wenn das so ist. Bitte sehr. ARME WELT.

Es ist wirklich unfassbar. Die Firma die 1984 in einem Werbespot vor Big Brother gewarnt hat, will nun auf persönlichen Endgeräten der Nutzer nach kriminellen Inhalten suchen. Gut gemeint, aber mit der gleichen Argumentation könnte man jetzt auch regelmäßige Hausdurchsuchungen bei allen Menschen starten. Wahnsinn !

Könnte man nicht die Fotomediathek auslagern und selbst verschlüsseln auf dem iphone ? Dann kommt da keiner ran. Als Fotos in einem verschlüsselten Ordner sichern.Wenn das beim iphone nicht geht aber beim Android phone werde ich sofort wechseln. Kein Bock das irgend wer meine Bilder checkt.

https://privatelightbox.procamera-app.com/de/private-lightbox.html

ProCamera bietet eine Private Lightbox Funktion (in-app-kauf) an, bei der, einmal aktiviert, alle Bilder in einem sicheren Ordner verbleiben.

Es werden doch sowieso nur Fotos gescannt, die in die Cloud geladen werden. Einfach keine Cloud nutzen, Problem gelöst.

Wenn Du bisher eine Cloud genutzt hast, wurden deine Fotos sowieso schon gescannt.

Und das Typische nackte Kind in der Badewanne kukt sich dann ein Apple Mitarbeiter an. Der is natürlich total vertrauenswürdig. Is klar Apple. Wer sagt mir das genau dieser prüfende Mitarbeiter nicht genau der ist der diese Bilder dann sammelt und verbreitet. ?

Das wird ein Eigentor von Apple.

Nochmals: Es werden nur Fotos gescannt, die in die Cloud geladen werden sollen. Die wurden bisher auch schon gescannt, aber auf der anderen Seite.

Edward Snowden hat es auf den Punkt gebracht:

wer heute nach Kinderpornographie sucht,

Der wird morgen nach allem anderen suchen können. Das ist das Ende der Privatsphäre auf Apple Geräten.

Blödsinn, das hätten alle schon bisher machen können, zum Beispiel via Spotlight. Das ist wieder typisches Aluhutdenken.

Es ist nicht die Aufgabe von Apple nach kriminellen Dateien auf einem iPhone zu suchen. Egal wie gut die Gründe sein mögen. Es ist das Versprechen nach Privatsphäre von Apple, dass kompromittiert wird.

Genau das ist das Problem. Es ist verständlich, dass Apple verhindern möchte, dass Kinderpornos in der Cloud und somit auf Apples Servern landen, denn allein damit würden sie sich theoretisch schon strafbar machen (ich vermute, in den USA ist ebenso wie in Deutschland der Besitz an sich schon verboten). Da die Foto-App ohnehin schon über die Möglichkeit verfügt, Inhalte zu erkennen, ist die technische Implementierung sicher nicht schwer.

Es kann aber nicht angehen, dass Apple sich hier zum verlängerten Arm der Justiz aufschwingt und eventuelle Funde and die Behörden meldet, und im Zweifelsfall Mitarbeiter sich die entsprechenden Fotos anschauen, um eine Entscheidung darüber zu treffen, ob es sich um illegale Aufnahmen handelt. Das widerspricht sämtlichen Versprechungen hinsichtlich der Privatsphäre der Nutzer.

Ok, dass iCloud serverseitig Fotos scannt, ist schon lange bekannt, und wie gesagt auch verständlich. Wer iCloud nicht nutzen will, kann es ja deaktivieren. Und zumindest ist Apple insoweit zurückgerudert, dass lokal wohl nur gescannt wird, wenn iCloud eingeschaltet ist. Aber trotzdem hinterlässt die Geschichte einen sehr schlechten Beigeschmack, da sie Missbrauch Tür und Tor öffnet.

Es hätte ausgereicht, wenn als illegal erkannte Dateien schlichtweg vom Upload ausgeschlossen würden und ansonsten nichts weiter unternommen wird. Damit wäre Apple rechtlich gesehen auf der sicheren Seite, und die Privatsphäre der User wäre weiterhin geschützt. Mir wäre so ein Scan vor dem Upload sogar lieber, denn dann kann ich sicher sein, dass heikle Bilder (sollte der Scanner Nacktheit oder andere „anstößige“ Dinge erkennen können) gar nicht erst (zudem noch unverschlüsselt) in der Cloud landen.

Genau so ist es, Saubär, einhundertprozentige Zustimmung!

Nein, ist es nicht, ganz im Gegenteil. Bisher wurden alle Fotos, die Du in der Cloud lädst (egal ob MS, Google, Apple, oder Amazon) sofort bei Eintreffen gescannt, bei positiven Ergebnis gesichtet und n die Behörden weitergeleitet. Anscheinend wusste es so gut wie niemand, aber so ist das Gesetz in den USA (und in 2 Jahren auch in der EU).

Das Problem dabei ist aber, dass der Cloudanbieter alle Fotos entschlüsseln kann (sonst würde es nicht funktionieren).

Wenn das aber vorher auf dem Gerät passiert, braucht Apple den Schlüssel nicht mehr.

Wenn Du aber keine Cloud nutzt, ändert sich nichts, da nur die Fotos, die in der iCloud Fotomediathek gespeichert werden sollen, vom Gerät vorher gescannt werden.

Das alles hat auch noch kein Datenschützer kritisiert. Es geht sich denen nur darum, dass man das noch erweitern „könnte“, wenn es Regierungen verlangen. Aber das ist hanebüchen, denn das könnten die auch so verlangen.

Sobald die damit anfangen ist apple für mich leider durch. Klar Apple war auch nie der top datenschützer egal wie viel zu geworben haben, aber das geht mir zu weit

Ausgerechnet in den USA zuerst??

Homeland, FBI, CIA und Co reiben sich doch schon die Finger und den Geifer vom Mund.

Endlich zugriff auf die iPhones der ganzen Terrorverdächtigen. (In den USA also aller Personen die u.a. Verschlüsselung und gesicherte Kommunikation nutzen)…

Wieso sollten Sie Zugriff haben? Du hast wohl nicht verstanden, was das iPhone vor dem Upload von Fotos macht.

Es gibt eine Möglichkeit auf das Gerät zuzugreifen!

Also nutzen es die Geheimdienste ja ganz bestimmt überhaupt gargarnicht aus, ist ja nur zur Bekämpfung von KiPo gedacht…

Neben dem diskussionsbedürftigem Vorgehen mal ein anderer Punkt:

Das Bilden von Hashes ist Energievernichtung, wenn diese nicht dem Zweck der Speicherung oder dem Validieren dienen.

Angenommen die Hashes werden nur aus diesem hier problematischen Kontext heraus gebildet, dann werden 100% der Hashes validiert, aber kein einziger erfüllt einen weiteren Nutzen für den Nutzer.

Werden diese seit jeher schon vor dem Upload in die iCloud gebildet? Das ist eine entscheidende Frage. Bildet Apple diese schon immer, um die Integrität der eigenen Fotos sicherzustellen? Die Bytes gehen durch den Äther und an zahlreichen Stellen kann ein Bit kippen.

Ich hatte schon kaputte Bilder in der iClouds Fotothek. Scheinbar gibt es hier keine Hashes, die die Integrität und Konsistenz sicherstellen.

Der Energiebedarf zum Bilden von Hashes ist auch der Grund weshalb sie beim Upload gebildet werden.

Da müssen die Daten zwangsläufig gelesen werden und in Pakete unterteilt werden.

So macht man das in einem Abwasch und brauch in der Summe zwar mehr Energie, aber hat eben diese auch sinnvoll genutzt.

Wäre eigentlich mal interessant zu wissen, wie sich der Energiebedarf erhöht, schließlich verfügt Apple ungefragt über den Akku.

Die verbesserte Datenintegrität der eigenen Bilder über Hashes wäre ein Pro-Argument gewesen.

Somit hätte man den Anwendern noch eigenen Nutzen vermitteln können.

Auch mit dem erhöhten Akkuverbrauch, der dann auch zum eigenen Nutzen beibringt.

Wie immer beim Aufgeben von Bürgerrechten wir ein anscheinend positiver Grund vorgeschoben. Wer dagegen ist, ist ein böser Na_i.

Zuerst angebliche Kinderp_bilder, bald schon andere Bilder.

Nach dem Onlinebanking fertige ich einen Screenshot der Überweisung an. Zukünftig muss ich damit rechnen, dass der Screenshot bei Apple und vielleicht noch anderen Diensten landet. Ich fotografiere Urkunden ab, zukünftig landen die Bilder bei Apple? Kein schöner Gedanke, kein Vertrauen zu Apple.

Du lädst diese Fotos von deiner Bank in die Cloud? Wenn nicht, dann werden die auch nicht gescannt, wenn doch wurden die immer schon gescannt.

Freu mich auf meinen nächsten Besuch im Store – die Mitarbeiter haben wie immer keinerlei Ahnung davon und werden sicherlich nicht wissen, was sie antworten wollen.

sind wir alle unterm Verdacht Pädophile zu sein, also?

Nein, warum? Wenn Du Fotos in eine Cloud lädst ist der Provider verpflichtet diese zu kontrollieren. Apple macht das jetzt auf dem Phone, alle anderen erst bei Ankunft in der Cloud. Erklär mal, was daran besser ist.

I am no longer accepting the Things i can not change.

I am changing the things i can not accept.

An den hirnlosen Moderator, der meine Nachricht mit Generalverdacht gelöscht hat – was war denn falsch?

Über Deinem Beitrag ist diese Nachricht zu sehen.

Bitte um Verzeihung… Ich war zu blöd den Kommentar zu finden.

Wenn ich das mit der Datenbank richtig verstehe hat Apple also die größte kinderporno-Sammlung der Welt ?

Nein, sie haben lediglich die Hashes der entsprechenden Dateien, nicht die Dateien selbst.

Und wie will Apple dann sichten?

Super Idee . Ist für euch in Germany sowieso nichts , da ihr ja bald mit Esel Karren fahrt LOL

Ich bin für Kameras in allen Haushalten. Das scheint ja keinen mehr zu stören. Ist ja kein Unterschied, warum erst über Apple gehen? Im Ernst – was passiert hier ?

Es gibt auch andere gute Smartphones. Tschüss Apple

Und deren Fotos in der Cloud werden nicht gescannt, gesichtet und weitergeleitet? Hast Du irgendwas verpasst?

Was viele hier vergessen oder nicht wahr haben wollen.

1. alle, start auf Verdachtsfall, werden gläsern und kontrolliert

2. eine private, statt rechtsstaatliche Institution, macht das

3. dieser Algorithmus ist möglicherweise nur der Anfang und lässt sich beliebig auf Homosexuelle (Polen), politische Gesinnung etc ausdehnen – je nach politischem Druck

4. welche Kriterien für das erzeugen der Hash relevant sind, sind nicht einsehbar

5. alle die glauben es geht um Nacktbilder – wer weiß das – siehe 4.

6. Da ja Cloud in aller Munde ist, auch zum Speichern der bereits gemachten Bilder, muss nichts versendet werden sondern dass Material ist schon da zum Abgleich.

7. alle Eltern die hier schreiben sie würden keine Nacktbilder von ihren Kindern haben oder machen – ein kurzes HaHa von einem Vater! Dass die nicht versendet werden glaube ich allerdings.

8. die Liste kann noch ewig so weiter gehen!

Wo ist das Problem? Apple prüft nur die Fotos vor dem Upload in die Cloud. Bisher haben sie es nach den Upload gemacht.

Was ändert sich denn für dich?

Wenn du meinen Kommentar gelesen hast weiß du was auch ändert und potenziell in der Zukunft gut ändern kann und wird .

Nein, es ändert sich gar nichts. Alle Fotos in der Cloud werden seit min. 3 Jahren genau so gescannt, bei Treffer gesichtet und an Behörden weitergeleitet.

Das ist genau das gleiche. Der Unterschied ist, dass das jetzt vor dem Upload passiert. Da, wie Du behauptest, sowieso fast jeder eine Cloud nutzt, ändert sich also rein gar nichts.

Hier wird ein viertes Gewaltenmonopol eingeführt:

Legislative

Judikative

Executive

Apple-Detective

Ohne richterlichen Beschluss darf keine Staatsanwaltschaft Bilder von mir sichten. Aber ein US Zensor bei Apple in den USA? Wird in Europa so nicht kommen. Aber was passiert, wenn ich in die USA reise um Tim in die Eier zu treten.

Deine Fotos in der Cloud wurden schon seit mehr als 3 Jahren gescannt und bei Treffern gesichtet. Wenn Du keine Cloud hast, dann hat sich das Problem sowieso erledigt.

Und Google, Amazon und Microsoft machen das schon seit Jahren in der Cloud, weil sie es müssen. Das hat dich auch nicht interessiert.

In God we trust, but iPhone user will be observed!

Wenn das kommt, werd ich wohl zu Android wechseln.

Und wo ist der Unterschied? Fotos in Clouds werden sowieso gescannt. Wenn Du nichts in die Cloud lädst, scannt auch das iPhone nichts.

Ich bin gespannt wie der Apple Kurs sich entwickelt. Sehr wahrscheinlich werde ich mich von Apple trennen.

Ich sehe das Ende von Apple wenn du deine drei Apple Aktien verkaufst. Es wird global Panikverkäufe auslösen und wird die Weltwirtschaft in den Abgrund reißen.

Spinner

Und warum? Weil deine Fotos jetzt vor dem Upload in die Cloud gescannt werden, statt hinterher?

Nutze keine Cloud und deine Daten bleiben wo sie sind. Wenn Du sowieso eine nutzt, dann wurden die seit 3 Jahren bereits gescannt.

Der Kurs wird wohl steigen, der der größte Teil der US-Amerikaner unterstützen das voll und ganz. Und der Schutz für die Kinder wird ein Renner in den USA werden. Das wird da schon seit Jahren von Eltern gefordert.

Next Step:

Demnächst ist auch Dein Kind dran!

Ein Screenshot vom Shooter-Game eines Jugendlichen und schon wird es zum Verbrecher…verurteilt durch Apple, der neuen Weltpolizei?

Ich bin bisher sehr von Apple überzeugt, doch was jetzt hier passieren soll, geht gar nicht.

In Deutschland wurden Kameras zur Überwachung auf Autobahnen mit Kennzeichen-Erkennung verboten, weil jeder Bürger einem Generalverdacht eines Verbrechens unterstellt wurde und jetzt kommt Apple und scannt Fotos auf den Geräten UND lässt diese noch von eigenen Mitarbeitern prüfen!?!

Damit würde sich neben dem Generalverdacht, dass alle Menschen erstmal Verbrecher sind, m.E. sogar jeder Apple-Mitarbeiter (welche die Fotos sichten) strafbar machen, weil dieser strafrechtliches Material von Minderjährigen sichtet, speichert und weiterleitet…

in Deutschland werden Strafverfahren dafür eingeleitet.

Ein absolutes No-Go!

Und was bitteschön machen die Eltern, dessen Kleinkind im Urlaub mal nackt am Pool oder Strand unbemerkt von einem Pädo fotografiert wurde?

Zack… schon in der verdächtigen Datenbank gelandet? Und Zack Fotos vom eigenen Kind gescannt…dann landet damit bei Apple-Mitarbeitern und danach kommen erstmal die Handschellen für die unbedarften Eltern? Da läuft was schief!

Je mehr ich darüber nachdenke umso mehr Probleme stelle ich fest! Ich werde meine Meinung mal direkt an Apple schreiben!

Schreibe es besser nicht, weil Du gar nicht verstanden hast worum es überhaupt geht.

Es geht sich ausschließlich um Fotos die in die iCloud geladen werden sollen und nur in den USA.

Fotos in allen Clouds werden schon seit Jahren mit den Hashes abgeglichen. Somit änder sich für dich nichts. Im Gegenteil: Eine US-Behörde kann nach dem Upload nicht mehr auf deine Fotos zugreifen, weil Apple den Schlüssel nicht mehr braucht.

Also nächstes überprüft Apple, ob wir uns aufm Klo lange genug die Hände gewaschen haben. Verstöße werden dann direkt ans RKI gemeldet.

Betroffene Hunde Bellen.

Früher als die Fotos noch entwickelt wurden, hat es niemanden Interessiert ob da einer oder mehrere Mitarbeiter eine Fotos sehen. Heute ist es ein No Go? Habt ihr was zu verbergen? Heute wissen doch eh alle Konzerne alles über uns. Daten werden verkauft, WhatsApp, Facebook und Instagram wird verwendet. Aufregen tut sich jeder, aber alle nutzen es. Ja sogar der Fingerabdruck wird einen Handy preisgegeben. Also was regt ihr euch auf? Solange ich nicht zu verbergen habe, brauche ich mich auch nicht aufregen.

Du unterstellst mit deinem ersten Satz ca. 270 Kommentatoren Pädophilie? Ab ins Körbchen dummer wauwau….

Ich glaube, das hat er nicht gemeint, sondern dass vermutlich nicht wenige derjenigen, die sich darüber beschweren eine Cloud nutzen, wo es seit Jahren genau so gemacht wird. Apple, Microsoft, Amazon, Google und Dropbox machen ganz genau das gleiche seit vielen Jahren. Die Fotos werden gescannt, bei positiven Fund persönlich gesichtet und an die Behörden weitergeleitet. Allein an die Schweiz gab es über 3000 Meldungen pro Jahr. Über 50 Pädophile konnten ermittelt werden.