Jetzt als Mac-Anwendung: Kimono baut APIs aus Webseiten

Die Webseite der Kimonolabs haben wir euch im Mai des letzten Jahres vorgestellt. Das Online-Angebot offerierte seinen Anwendern einen kostenlosen Webscraper, mit dessen Hilfe sich auch statische Webseiten so aufbereiten ließen, dass anschließend auf ein RSS-Feed, ein Datenpaket im JSON-Format oder eine umfangreiche API zugegriffen werden konnte.

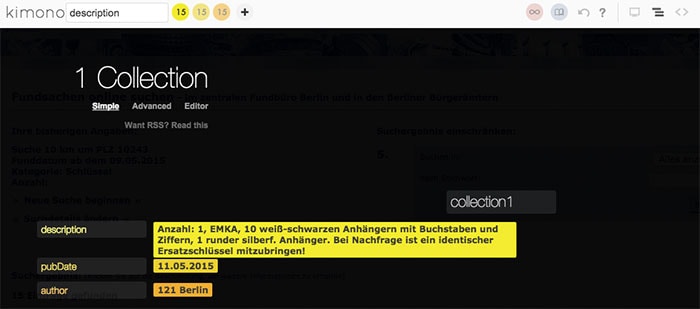

Mit dem weitgehend automatisierten Angebot konnten Anwender beliebige Webseiten in eine dynamische Datenquelle verwandeln. Wir haben den Webscraper der Kimonolabs damals etwa dafür genutzt, die unglaublich unübersichtliche Webseite des Berliner Fundbüros automatisiert auf die zuletzt abgegebenen Schlüssel zu überprüfen und haben die Ergebnisse anschließend als RSS-Feed ausgegeben.

Eine elegante Option, die uns nicht nur den täglichen Besuch der Online-Präsenz des Fundbüros erspart hat, sondern auch dafür sorgte, dass wir die offizielle Suche nicht jeden Tag aufs Neue mit unseren Suchkriterien bestücken mussten.

Jetzt machen die Kimonolabs leider zu. Im offiziellen Hausblog angekündigt, wird das Unternehmen zukünftig mit Palantir zusammenarbeiten und seinen Webdienst nicht mehr im gewohnten Umfang anbieten.

Doch es gibt auch gute Nachrichten. Um den bisherigen Anwendern der Kimono-Infrastruktur nicht einfach den Strom abzudrehen, bietet Kimono seinen Webscraper jetzt als Mac-Anwendung an, der sich zumindest lokal genau wie bislang nutzen lässt. Der 270MB große Download hat keine Online-Abhängigkeiten und lässt sich auf dem eigenen Mac mit wenigen Mausklicks starten.

Anschließend könnt ihr die Kimono-App genau so einsetzen wie die bislang angebotene Webseite.

Kimono for Desktop offers a similar experience and much of the same utility as the cloud hosted product. Available for both Mac OS X and Windows, Kimono for Desktop integrates with a new version of the chrome extension and performs all crawling locally on your machine.

Ihr verliert täglich euren Schlüssel?

Nein, hat auch niemand gesagt.

Es geht darum, dass in dem Falle, falls man seinen Schlüssel verliert, man so nicht dauernd die Webseite des Fundbüros kontrollieren muss, sondern die neuen Einträge per RSS aufruft und man solange den RSS Feed verfolgt, bis eventuell der verlorene Schlüssel als Eintrag im RSS Feed auftaucht.

Genaues Lesen erspart dämliche Fragen und Kommentare.

Kann man damit auch einen RSS Feed eurer Seite basteln, der nicht nur zwei Zeilen enthält und einen dazu zwingt, dann doch manuell die Seite zu laden?

Kennt jemand brauchbare alternativen?

Habe mir bis jetzt mal import.io, apifier, scrapinghub und parsehub angeschaut, werde aber mit keinem so richtig warm :(