iPad als Simultanübersetzer

iPadOS 15: Die automatische Übersetzung im Video

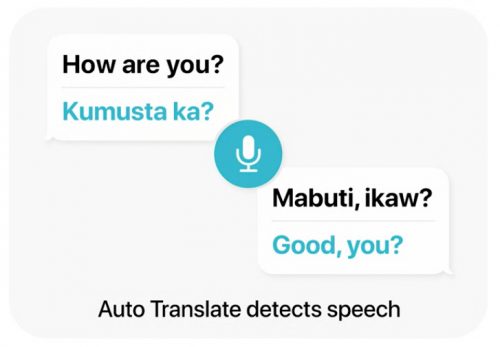

Mit iPadOS 15 wird das iPad nicht nur die bereits vom iPhone bekannte Übersetzungs-App erhalten, Apple will die Funktion der Anwendung auch umfassend erweitern. Allem voran kommt hier die neue Funktion „Auto Translate“ ins Spiel, mit deren Hilfe das iPad Gespräche automatisch und in Echtzeit übersetzen kann.

Im Gesprächsmodus lauscht das iPad dabei auf die beteiligten Gesprächspartner und erkennt die gesprochene Sprache automatisch. Es muss lediglich festgelegt werden, zwischen welchen beiden Sprachen die App übersetzen soll. Anschließend übersetzt die Anwendung das Gesprochene direkt und liest das Ergebnis in Gesprächspausen vor, ohne dass hierfür eine Taste gedrückt werden muss.

Apples neue Übersetzungsfunktion wird sich systemweit in iPadOS integriert finden. Eine Übersetzen-Taste wird beispielsweise künftig auch das Kontextmenü bei der Textauswahl erweitern. Ebenso können mit „Livetext“ in Fotos erkannte Textpassagen mit der Übersetzungsfunktion kombiniert werden. Apple bietet seine systemweite Übersetzungsfunktion in Zukunft auf dem iPad, dem Mac sowie unter iOS an. Dabei kann der Nutzer entscheiden, ob er die Sprachpakete herunterladen, und die Übersetzungsfunktion dann ausschließlich lokal auf seinem Apple-Gerät verwenden will.

Apples automatische Übersetzung im Video

Im Praxiseinsatz können sich Apples neue Übersetzungsfunktionen von Herbst an beweisen. Entwickler haben über die erste Vorabversion von iPadOS 15 jetzt schon Zugriff auf die neue App.

Wer sich für die Neuerung interessiert, sollte sich das unten eingebettete Video von AppleInsider zu Gemüte führen. Ihr seht darin, dass die Live-Übersetzung schon erfreulich gut funktioniert, allerdings verbunden mit einem Hinweis, den man keinesfalls außer Acht lassen sollte. Der Apple-Übersetzer ist längst nicht perfekt und insbesondere dann, wenn die beiden Gesprächspartner tatsächlich keine gemeinsame Sprache sprechen und die Ergebnisse nicht kontrollieren können, ist man vor Missinterpretationen und auch peinlichen Überraschungen nicht gefeit.

Die Vorstufe zum Babelfisch – jetzt noch die Verbindung zu den AirPods Pro – Thanks and goodbye for the fish

Sehe gerade dass man nicht 2 conference calls parallel haben und noch einen Kommentar schreiben sollte: „Goodbye and thanks for all the fish“ ist die richtige Formulierung.

Die Mäuse werden es Dir nachsehen. Pass auf Dein Handtuch auf.

naja, wenn er den „Babelfisch“ verabschieden möchte, da ja die AirPods(Pro) die Funktion dann erfüllen, passt seine Quote denke ich schon ; )

:-) … der Versprecher wäre bei Fremden echt peinlich gewesen! Auch wenn’s noch nicht perfekt ist, in 1-2 Jahren wird’s perfekt sein und dann ist es super nützlich – vorausgesetzt, dass ist dann auch in iOS intergiert, denn wer läuft schon immer mit seinem iPad rum …

Das macht doch Google Translate schon seit ewigen Zeiten, oder sehe ich da was falsch?

Jetzt ist es aber von Apple also ein superduper Feature.

Naja, wenn das Systemweit integriert ist, ist es schon etwas mehr ;-D

Beim Google Übersetzer -> Transkribieren wird der Text leider nicht vorgelesen. Sollten die mal ändern…

Solange mich Siri mich nicht mal auf Deutsch versteht…

Bzw. im Wechsel sprich ich kann nicht ihr nicht beibringen: Rufe Mum oder Dad an. Sondern nur D-a-d ;-)

Hast du es denn mal mit der „Spitznamen“ Funktion in IOS versucht? Ich meine, ich verstehe schon, was du da sagst, und ich würde mir auch eine wortweise Spracherkennung wünschen, aber solange das noch nicht funktioniert, sind diese „Workarounds“ durchaus nützlich.

Bei mir funktioniert das so recht gut (in meinen Anwendungsfällen).

Ich glaube aber, dass das sicher auch in den nächsten Jahren noch deutlich besser wird und dem Babelfish (oder dem Universaltranslator aus Startrek) immer näher kommt.

Nur fürs iPad? nicht für iOS?

Die Übersetzungen waren mehr als mau.

Verstehe auch beide Sprachen so wie im Video. Während man English -> Spanish noch akzeptieren konnte, war Spanish -> English schon bedeutend schlechter. Das gleiche Problem hat Google auch. Warum nur? Schon merkwürdig. Ist man da ignoranter oder woran liegt das? Deepl kann das alles viel besser. Es ist wirklich erstaunlich, wie wenig man dessen Übersetzung nach-korrigieren muss.

Wenn das so in dieser Form von Apple in iOS15 erscheint ist das schon etwas peinlich. Dann lieber bis iOS 16 warten.

Siri ist für mich auch eine Baustelle. Mit ihr stehe ich immer auf Kriegsfuß. Sie mag mich nicht. Wenn ich schon den Satz höre.

Ich weiß nicht was du meinst–Pause–Rudi. Soll ich für Dich im Internet nachschauen? Nein Danke, kann ich selbst.

Apple, Das Übersetzungsdingens behaltet mal lieber in dieser Alpha vErsion. :)

Bitte nicht veröffentlichen und dem Volk glaubhaft machen, dass das gut ist.

Gerade Live Text setzt aber meines Wissens nach leider Apples Prozessoren voraus.

Ja und. Alle iPad und alle iPhones haben das. Und alle zukünftigen MacBooks

Aha… Mein iPhone 11 hat einen M1? Mein iPad Pro 2020 hat einen M1? Mein MacBook Pro 2017 hat einen M1?

Du hast aber nicht „M1“ geschrieben, sondern „Apple-Prozessoren“. Und die sind in den genannten Geräten rundweg drin. Denk nochmal darüber nach ;-)

Auch ein A12, A10, A11x sind Apple-Prozessoren

Ich verstehe euch, aber wenn man weiß, dass überall ein M1 drin sein muss, dann versteht man auch, wie ich es meine. Wenn man es nicht weiß, gibt es eine Reaktion wie die von Markus. ;P

Euch = Dich

Ich habe das Pendant von Microsoft getestet mit der chinesischen Sprache. Das ist, bis auf einige kleine technischen Probleme(bei Microsoft ja an der Tagesordnung) ein geniales Tool (Microsoft Translator) mit überragenden Übersetzungsfähigkeiten. Im Übrigen empfiehlt es sich auch mal im AppStore nach „Microsoft“ zu suchen. Die haben einige interessante Programme drin (mal abgesehen von den Mainstream-Sachen wie Word und Excel).

Sorry. Aber MS Translator ist mit Abstand der aller schlechteste. Das geht gar nicht.