Mit dem Laser durchs Fenster

Forscher täuschen Sprachassistenten mithilfe von Lichtstrahlen

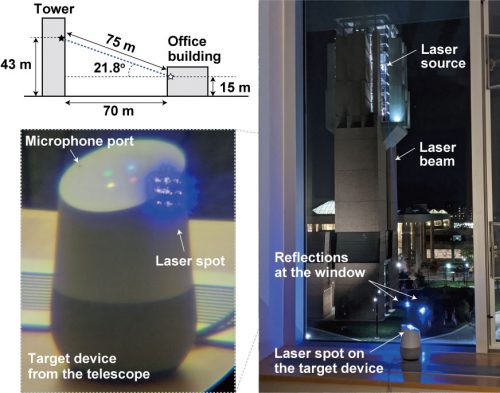

Einer Forschergruppe ist es gelungen, mithilfe von Laserstrahlen Kommandos an Sprachassistenten wie Siri, Alexa oder den Google Assistant zu übermitteln. Unhörbar und nahezu auch unsichtbar, teils auch durch Fenster hindurch. Allerdings erfordert das Verfahren einen verhältnismäßig großen Aufwand und darf somit aktuell eher als warnendes „Proof of Concept“ verstanden werden. Details zu den Erkenntnissen wurden unter dem Titel „Light Commands“ veröffentlicht.

Das Experiment gründet auf der Tatsache, dass ein Mikrofon erfasste Geräusche in elektrische Signale wandelt und vergleichbares auch bei intensiver Lichteinstrahlung geschieht. Mithilfe von Laserstrahlen gelang es den Forschern so, die Mikrofone der Sprachassistenten zu täuschen. Und zwar nicht nur bei Geräten wie dem Amazon Echo oder Google Assistant, sondern auch bei Smartphones oder beispielsweise einem iPad.

Laser sendet Sprachbefehle

Mithilfe von bestimmten Lichtfrequenzen können gezielt Sprachkommandos imitiert und die Assistenten so zu Reaktionen veranlasst werden. Besonders kritisch wäre hierbei natürlich das automatische Öffnen von Türen oder Garagentoren. Dies gelang abhängig vom Gerät teilweise auch aus größerer Entfernung, so reagierten Smart Speaker auf einen starken Laserstrahl wohl aus bis zu 50 Metern – in Einzelfällen sogar aus über 100 Metern, ein iPhone aus immerhin zehn Metern, bei den getesteten Android-Telefonen mussten die Forscher auf knapp fünf Meter ran. Die Fensterbank scheint also kein besonders guter Platz für das Aufstellen eines smarten Lautsprechers.

Wenngleich die praktische Umsetzung dieser Erkenntnisse hohes Fachwissen und Aufwand erfordert, sollten die Hersteller das Wissen darüber zur Verbesserungen ihrer Produkte verwenden. Google und Amazon haben auf Anfrage des Magazins Wired dann auch bestätigt, dass sie die Ergebnisse entsprechend auswerten, Apple hat eine Stellungnahme verweigert.

Das Apple nicht mal ein „wir werden und das ansehen“ rausbringt, zeigt von nicht gerade von einer gewissenhaften und vorausschauenden PR-Abteilung.

Apple will sich doch nicht auf die gleich Stufe stellen, wo schon google und Amazon draufstehen! ;-)

Einfach die Fenster nicht putzen! Wenn da erstmal richtig Dreck drauf ist sollte der Angriff nicht mehr funktionieren;)

So kann Apple abwarten bis mal was passiert, und dann sagen „Oh das haben wir nicht erwartet / gewusst!“

Das ist mal wieder eine Erkenntnis die keiner braucht…

die Hälfte der Bevölkerung lässt im Winter das Fenster gekippt, am besten in der Nacht und ohne Rollläden. Ich glaube da braucht niemand über die „Gefahr“ der Alexas oder Siris diskutieren…

Wir werden wirklich immer bekloppter…

+1

Aber es gibt ja auch noch welche mit Verstand ;-)

Relevanz-Level = 0

Das Fenster im Winter gekippt zu haben über Nacht ist nicht die beste Idee. Ich hoffe, dass das nicht die Hälfte der Bevölkerung tut.

Warum nicht? Ist frische Luft so schlecht?

Warum sollte das keine gute Idee sein? Ich kenne genügend Leute, die nur bei geöffnetem Fenster schlafen. Ich war früher auch so…

Das zum Thema Klimawandel.

Ein gekipptes Fenster ist ein offenes Fenster. Viel Spaß beim Erklärungsversuch gegenüber der Versicherung, wie die netten Besucher die Bude leergeräumt haben.

Ich finde diese Hacking-Berichte immer wieder faszinierend. Im Grund machen die Geräte ja genau das was sie sollen: Sie reagieren auf entsprechende Eingaben mit der Ausführung der zugehörigen Kommandos.

Das Problem ist nur, dass „genau das was sie sollen“ nicht dasselbe ist wie das „was die Entwickler dachten, was sie tun sollen“. Die Aufgabe der Hacker ist es also „nur“ herauszufinden welche Abweichungen es zwischen der „gewünschten/angestrebten“ Funktion und der tatsächlichen Funktion gibt um diese dann auszunutzen.

Auf die Idee die Mikrofone per Laser zu bedienen muss man erst einmal kommen. Respekt vor dem technischen Verständnis und Einfallsreichtum.

Yep; das ist schon eine geniale Idee gewesen…

Dem muss ich nach dem Lesen des Artikels absolut zustimmen.

Das zeigt ja eigentlich nur mal eindrucksvoll, vor Allem für technisch/programmiertechnisch unbedarfte, an was alles gedacht werden muss. Und dass auch bei Software Updates/Neuerscheinungen nicht alles rund laufen kann. Siehe Fingerabdrucksensor, FaceID usw.

meinen vollen Respekt für die Pinky and Brains.

…solange sie nicht die Weltherrschaft an sich reißen wollen… ;)

;-)

Also beim Google Home sehe ich ja oben die Mikrofonöffnungen und auch Alexa hat diesen Ring an dem man die Mikrofone deutlich vermuten kann. Aber der HomePod ist ja von außen mit einem Stoff über mehrere Ebenen überzogen… So wie es scheint muss der Laser irgendwie direkt auf das Mikrofon leuchten oder nur in dessen Nähe? Wäre das denn beim HomePod möglich?

Schau dir doch noch mal die eingebundenen Fotos im Artikel an. Es reicht wenn der Laser das Gerät in der Nähe des Mikrofons trifft.

Naja, wirklich? Oder ist der Laserstrahl einfach nur so groß um eine höhere Wahrscheinlichkeit zu haben auf jeden Fall auch die Mikrofone zu treffen?

„The positioning didn’t need to be especially precise; in some cases they simply flooded the device with light.“

Klingt aber trotzdem so als wäre der HomePod mit seinem Stoff und stabilem Innenleben gut davor geschützt. Der Artikel geht auch nur auf Alexa und Google Home ein, es werden auch iPhones erwähnt, die aber immer eine Autorisierung durch Touch/Face ID danach erfordern und daher auch gut geschützt sind.

Ja gibt auch sehr viele Einbrecher, die derart intelligent sind. Wieder mal Bildzeitung hier. Panik vor nichts.

Wenn man nichts anders zu tun hat, dann macht man halt solche Tests und scheucht alle auf. Oh Mann