Neue Funktion startet in den USA

Continued Conversation: Google Home akzeptiert fortan mehrere Befehle am Stück

Die Kommunikation mit dem Google-Sprachassistent wird einfacher. Zunächst allerdings nur für Nutzer in den USA. Google hat dort heute die Funktion „Continued Conversation“ freigegeben.

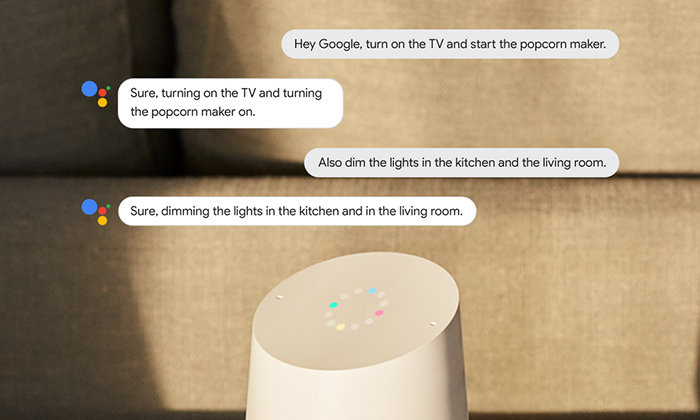

Continued Conversation erlaubt es, dem Google Assistant mehrere Kommandos am Stück zu geben, ohne jedes Mal aufs Neue mit „Hey Google“ beginnen zu müssen. Ein von Google angeführtes Beispiel wäre „Hey Google, wie ist das Wetter heute? … Und wie wird es morgen? … Setze eine Regenjacke auf meine Einkaufsliste … Und erinnere mich, morgen einen Regenschirm mitzunehmen … Danke!“.

Das abschließende „Danke“ oder auch ein „Stop“ führt dazu, dass der Google Assistant die Konversation als abgeschlossen betrachtet und nicht versehentlich weitere Gesprächsfetzen als Aufgabe oder Frage interpretiert werden. Unabhängig von diesem abschließenden Kommando endet die Aufmerksamkeit des Assistenten nach mehreren Sekunden Pause auch automatisch wieder.

Google will damit eine natürlichere und unkompliziertere Kommunikation mit dem hauseigenen Sprachassistent ermöglichen. Die neue Funktion ist auf Google-Home-Lautsprechern verfügbar, muss allerdings von deren Besitzer über die Google-Home-App aktiviert werden. Google hat nicht verlauten lassen, wann die Continued Conversations in weiteren Ländern verfügbar sind.

Kann Alexa schon länger.

Merke ich in Deutschland nichts von. Ist nicht flächendeckend ausgerollt worden.

Habe ich von Deutschland gesprochen?

Hast deutsch auf nem deutschen Blog geschrieben. Würde sagen deutschsprachiger Raum ist die Referenz oder? Alexa hat es folglich noch nicht für 90% der Leser hier.

So so

eine spracherkennung, die im zweiten satz schon wieder vergessen hat, was man im ersten gesagt hat, ist nicht besonders intelligent. dass ein sprachassistent nicht zweimal mit „hey“ angesprochen werden muss, macht ihn auch nicht intelligenter, denn im zweifelsfall muss man ihm jetzt auch noch sagen, dass man nicht mehr mit ihm redet. intelligent wäre, wenn er den kontext verstehen würde bei zwei aufeinander folgenden befehlen wie „mache ein foto“ und „versende es“.

Wo denn? Hier in Europa wohl eher nicht.

Habe ich geschrieben, dass DU von Deutschland sprichst?

Ja du hattest davon gesprochen das du davon in Deutschland nichts merkst und das es nicht flächendeckend ausgerollt sei. Daher meine Antwort.

In Deutschland ist die Funktion noch gar nicht ausgerollt, englischsprachig dagegen schon.

Falsch.

Lies Deine als Frage formulierte Unterstellung und dann meine als Antwort formulierte Frage, speziell dass grossgeschriebene Wort, nochmal.

Gib Deinem Ego weniger Raum, dann passt es.

Ich ergänze, Wortklauberei ist anstrengend und wenig zielführend.

Ist doch tatsächlich mal einer auf die Idee gekommen, das Wort „und“ für diese Zwecke zu nutzen. Darauf warte ich nun seit Jahren… und verstehe mehr oder minder nicht, warum das so schwer und mittlerweile nicht schon Standard ist.

Alles was wir bisher kennen hat mit KI (künstliche Intelligenz) eigentlich nichts zu tun; höchstens mit sehr guter Sprecherkennung.

Es muss ja alles noch in recht engen vorgefertigten Formulierung-Grenzen gesagt werden. Auch die allseits hochgelobten Skills bei Amazon ändern an dieser Tatsache leider nichts.

Daher ist und war das, was Google jetzt macht, eben noch lange nicht Standard und es wird sicherlich auch noch eine Weile dauern, bis das soweit ist!

Das ist so nicht korrekt.

Es ist zwar richtig das der Sprachrahmen meist sehr eng gefasst ist, was aber mehr daran liegt das zB. Entwickler sich nicht die Mühe machen ein ausgefeiltes Sprachmodel zu erstellen. So lange keine KI im weiteren Sinn ein ähnliches Verständnis hat wie ein Mensch, müssen beim Sprachmodel möglichst viele Eventualitäten eingeplant werden. Dann kann die dahinter stehende KI bzw. das Machine Learning entsprechend viele Möglichkeiten lernen, verstehen und über ein universelles Sprachverständnis auch ähnliche Ausdrücke der Nutzer berücksichtigen und erkennen. Allerdings ist das zB. nur innerhalb von Skills möglich, nicht beim Skill Aufruf. Daran wird aber auch schon gearbeitet in dem zB. Alexa bei Anfragen von Nutzern jetzt anfängt selbstständig mögliche Skills abzufragen, ob sie die Anfrage des Nutzers beantworten können. Ist das der Fall kann sie die Antwort präsentieren ohne das der Nutzer den Skill kennen oder aktiviert haben muss. Es geht also in die richtige Richtung.

@Philip

Das alles hat nichts mit KI zu tun. Auch so ein Sprachmodell ist letztendlich nur ein festgelegter Algorithmus mit vielen Verweigungen, die per IF-THEN oder Trial-and-Error bzw. einer Kombination aus beidem „durchlaufen“ werden.

Eine echte KI würde auf Grundlage von Semantik und Beispielen neue Erkenntnisse gewinnen und demzufolge mit der Zeit besser verstehen und reagieren sowie auch die Semantik selbst erweitern.

Da sind alle derzeitigen Systeme noch lange nicht. Der erste Schritt, der Aufbau eines Semantikgraphen, ist Google bereits angegangen. Aus meiner Sicht geht das aber bzgl. KI auch in die falsche Richtung, da dieser Graph für diese Zwecke bereits viel zu mächtig und festgefahren ist (KI muss selbst lernen, wie ein Kleinkind).

Verweigungen -> Verzweigungen

Und Siri aktuell: „Hey Siri, wie steht es derweil zwischen Argentinien und Kroatien?“ „Ich kann mich nicht beklagen“…